蘋果公司與普渡大學(Purdue University)的研究人員共同開發了一種名為 DarkDiff 的新技術,該技術將基於擴散的生成模型嵌入到相機的影像信號處理(ISP)中,以恢復極低光環境下拍攝的真實細節。這項研究顯示,DarkDiff 在實驗室測試中能顯著改善夜間照片的清晰度,儘管仍需解決計算成本和生成內容的風險。

DarkDiff 的核心在於其創新性地將預訓練的擴散模型重新任務化,這些模型源自開源的 Stable Diffusion,旨在從相機的線性 RGB 影像(經過初步的 ISP 步驟如去馬賽克和白平衡處理後)映射到最終的 sRGB 圖像,進而恢復在極暗環境中拍攝時丟失的細節。

在技術上,早期的 ISP 階段仍然負責處理感測器特定的操作(如白平衡和去馬賽克),而 DarkDiff 則在此基礎上進行去噪和重建最終影像,使用擴散取樣來平衡影像的真實性與生成先驗。該系統利用局部注意力機制來保留影像的局部結構,並限制重建過程中的「幻覺」現象(即生成的內容不真實)。

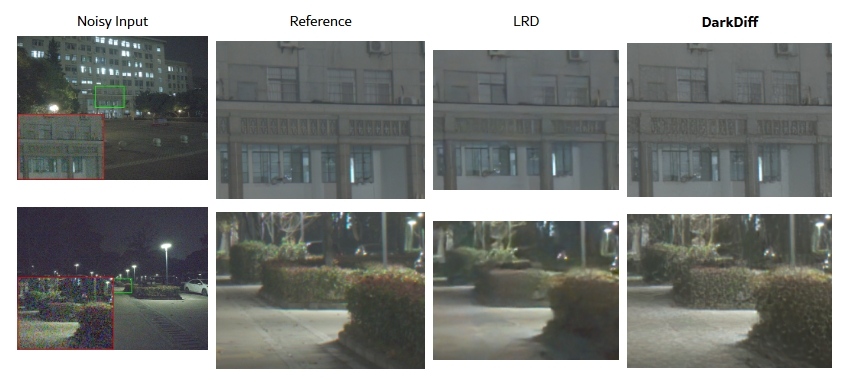

研究團隊在非常短的曝光時間下測試了 DarkDiff,拍攝的例子包括曝光時間僅為 0.033 秒的夜間照片,並將其輸出與使用三腳架拍攝的參考照片(曝光時間長達 300 倍)進行比較。結果顯示,DarkDiff 在感知品質指標和視覺比較上超越了當前最先進的原始增強和擴散基準。

▲ DarkDiff 能生成建築物圖案的細節以及灌木叢的紋理。目前最先進的方法 LRD 則生成了過度平滑的影像,且缺乏細節。(Source:論文)

然而,研究人員指出,這種基於擴散的處理方法在計算上顯著慢於傳統方法,可能需要雲端處理來彌補高計算需求,否則在手機上本地運行會迅速耗盡電池。此外,研究中還提到在低光場景中對非英語文本的辨識存在限制。

值得注意的是,該研究並未暗示 DarkDiff 將很快應用於 iPhone,但這項工作展示了蘋果在計算攝影領域持續的關注。隨著消費者對相機功能的需求超過了裝置內部的物理限制,這個領域在整個智慧手機市場中變得越來越重要。

(首圖為示意圖,來源:Unsplash)