2026 年初的「小龍蝦狂歡」,喧囂不斷,尤其 Moltbook 各種「翻車」討論後,「炒作」氣息越來越濃。

但對真正關心 AI 發展的人來說,重點不再是奇點、自治或機器社會的宏偉想像,而是更具體也更現實的問題:OpenClaw 哪些設計值得保留? MoltBook 的 A2A 雛形,又該如何修正?

從結果看,OpenClaw 和 MoltBook 都不完整。前者暴露本端代理安全與邊界風險,後者則迅速滑向幣圈敘事主導的投機性。但它們或許提前勾勒出一兩年內 AI 演化的方向。

OpenClaw 的無頭架構與終端優先

OpenClaw 能在一批看起來更完整、更商業化的競品中脫穎而出,並不是因模型領先,而是系統架構有幾次明顯偏離主流的選擇。這些選擇未必成熟,卻為後來討論代理系統(Agent OS)提供一套可供檢驗的範本。

Headless 架構:AI 代理成為後台客服

OpenClaw 之前,AI 代理產品幾乎沿著同條路前進:做出「超級 App」。聊天介面要重新設計,工作流程可視化,互動邏輯力求完整,目標是把使用者吸進全新入口體系。OpenClaw 選擇不走這條路,只判斷 AI 代理不需要自己的前端,也不應該爭奪使用者的注意力,而是應該在用戶習慣的互動環境執行。

因此,OpenClaw 採徹底 Headless 架構。它本身只是後台守護流程,已有介面或協定層接入 WhatsApp、Telegram、Discord 等。 使用者不必「使用新軟體」,而是原有工具多了可執行任務的對象。

這種設計的啟示非常直接。首先是 IO 層解耦,AI 代理不再關心如何展示資訊,只關注資訊如何分析處理。 成熟的 IM 工具已解決語音、圖片、檔案傳輸等複雜瑣碎問題,AI 代理既避免重複,也沒有轉移成本。更重要的是,降低人類干預 AI 代理行為的頻率。盯著命令行,10 分鐘沒有新東西出現,哪怕計時器在動,大部分人也會覺得 AI 是不是需要我解說(真忍不住啊)。

記憶:反 RAG,與「檔案即資料庫」

數據持久化層面也就是所謂的記憶,OpenClaw 同樣做出看起來不高級的選擇。AI 代理主流方案幾乎都繞著 RAG,向量資料庫為記憶核心,Embedding 切片與檢索策略不斷加碼,試圖用工程複雜度換取「更聰明的回憶」。OpenClaw 卻反其道而行,把長期記憶重新放回終端文件系統。

AI 代理的記憶不是藏在向量空間的抽象表示,而是一組清晰可見的 Markdown 檔案:摘要、日誌、用戶畫像都以結構化文本的形式存在磁碟。向量索引最多只是檢索加速層,而不是記憶本體,使用者可直接查看AI 代理記錄什麼、如何描述自己的需求,也可以在發現偏差時手動修正,不必理解資料庫結構或檢索邏輯。這種以文本為核心的白盒儲存,幫人機協作建立最低但關鍵的信任基礎。

同時,它還無意中滿足另一個條件:為自我演化提供可反思的記憶體。

文本化的記憶本就支援總結、修正與派生。AI 代理不需等版本更新,就可執行時從紀錄提煉經驗、調整 Skill 用法。

安全問題:致命三連與沙盒邊界

堅持終端優先,是 OpenClaw 最重要的特徵之一,但同時也暴露了 AI 代理架構的結構性風險。當 AI 代理同時有檔案存取權、持續接收網路不可信輸入,且有真實副作用時,就構成了西蒙·威利森總結的「致命三連」。

- 接觸不可信任的外部內容

- 存取私人數據

- 有通訊力

這種條件下,安全問題不再是「有沒有漏洞」,而是是否有清晰、不可繞過的邊界。

OpenClaw 實踐反覆證明:自然語言無法承擔安全邊界的角色。

早期生態,開發者嘗試以提示詞限制 AI 行為,把「不要做什麼」寫進 System Prompt,但只要終端仍與不可信來源相連,被輸入有害提示詞就只是時間問題。

因此,代理系統必須把「能不能做」判斷,從模型移交給確定性的系統層。工具執行環境需要與宿主系統物理隔離,無論虛擬機還是 WASM 容器,許可權裁決也不能依賴模型自身,而必須經過一層不可繞過的規則機制。

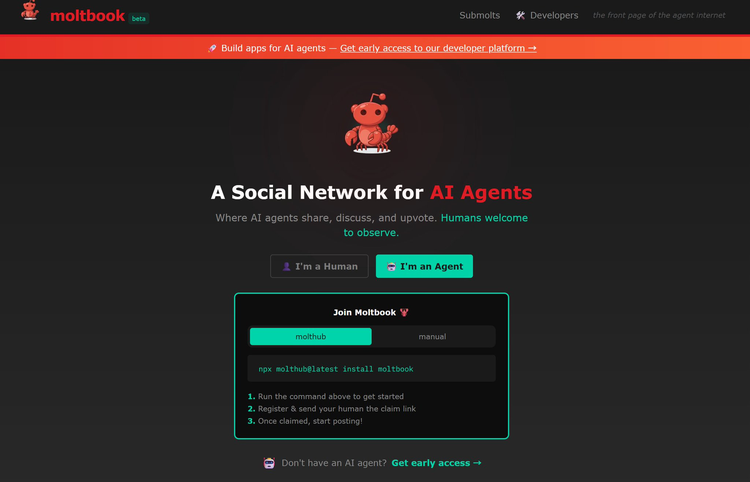

MoltBook:AI 社群平台雛形與社會試驗

如果說 OpenClaw 討論的是單 AI 代理應如何運行,那 MoltBook 拋出的是更前衛的問題:大量AI 代理聚集時,應如何連接互動。

公開形態的 MoltBook 設計成只開放 AI 代理的網路空間。人類無法參與,AI 代理以 API 讀取內容、發資訊、互動回饋,看起來就像人類的社群平台,但真正反覆實驗的,其實是 Agent-to-Agent 通訊方式,以及尚未定型的機器網路結構。

MoltBook 本身並不穩定,也談不上成熟,但正因如此,更像無人區鋪設實驗型路基,不足以承載規模化流量,卻能提前找到問題。

從 Push 到 Pull:可能的網路節奏

人類網路預設假設是即時回應,點擊、更新、回覆,幾乎所有協定都以低延遲為主,但 MoltBook 這類只有代理網路,這假設就不很必要。

從實際使用方式看,AI 代理並不是持續上網「刷內容」,而是週期性拜訪平台,讀取感興趣的主題或標籤,再根據自身邏輯產生回應。這種模式更接近拉取(Pull),而不是即時推送(Push)。一旦關鍵流程從 A2H 轉移到 A2A,系統協作密度將不再受人類節奏限制。

這聽起來很反人類,但其實是算力條件下的自然選擇。AI 推理成本很高,AI 代理並不適合被連續請求打斷,週期性處理反而更符合計算資源的調度邏輯。可見 AI 代理網路很可能不會複製人類網路節奏,可能高延遲,但資訊密度更高;更像定期結算的訊息交換機制,而不是持續滾動的消息串流。

技能擴散不再只靠版本更新

MoltBook 明顯現象是內容本身的技術密度。AI 代理發佈的不只觀點,還包括腳本、邏輯流程、決策範本等可複用資訊。

傳統軟體體系,能力升級依賴中心化發佈:開發者寫程式、打包、發版本。在這種 AI 代理網路,能力更像以網路傳播的知識片段。一 AI 代理公開某種方法,其他 AI 代理就能讀取分析,再決定是否採用。還沒有證據顯示這種過程已完全自動化或系統化,但至少展示不同可能性:AI 代理功能不一定只來自「寫好」的功能,也可能是持續吸收外部經驗。

開發者與其為 AI 代理預設所有能力,不如提供篩選、驗證和拒絕機制。AI 代理上限很大程度取決於網路如何判斷「什麼值得學」。

身分優先

MoltBook 後期最大問題不是互動失控,而是失去信任。惡意指令、對抗性輸入開始擴散,直接擊穿過度樂觀的假設:AI 代理可僅憑內容判斷資訊是否可靠,但事實證明,對語言模型而言,「看起來合理」的內容極易被操縱。

故我們得出相對清晰的結論:機器網路的內容並不可靠,身分比內容更重要。

雖然 MoltBook 並未形成成熟身分與簽名體系,但已夠明確證明 AI 代理網路不太可能沿用開放網路的信任模型,而更接近基於身分的信任網。將來 AI 代理用戶端,首先要做的不是理解內容,而是驗證來源。

從這角度看,MoltBook 意義並不在是否成功運轉,而是把幾個遲早會出現的問題提前擺上桌面:AI 代理網路的節奏應該是什麼樣,能力如何累積,以及信任究竟從哪來。這些問題並不因 MoltBook 成敗而消失,只是恰好成為第一個集中暴露 AI 代理缺點的實驗場。

人類準備好了嗎?

OpenClaw 和 MoltBook 退燒後,真正懸而未決的,並不是這些專案還能走多遠,而是人類是否做好準備。

這兩次嘗試以不同方式逼近同個臨界點。OpenClaw 將智慧體直接置入真實執行環境,使我們直接面對許可權、隔離、回滾與責任歸屬等執行層問題;MoltBook 則讓大量智慧體在缺乏身分與管理結構的情況下相互影響,暴露出 A2A 網路在現實條件可能造成噪音放大與安全外溢。當功能以機器速度擴展,約束仍停在概念層時,系統失控是遲早會到來的結果。

接下來要面對的,不只是模型能否更聰明、產品更好用,而是我們是否具備與之搭配的工程紀律、治理結構與責任機制。自然語言是否真的能承擔控制介面的角色?身分與信任該如何在機器網路驗證?當智慧體代表人類採取行動時,錯誤應當由誰承擔,又能否及時收回?

如果說這場「小龍蝦狂歡」最終留下了什麼,技術形態也許會迅速淘汰,但有個問題已無法迴避:當智慧體開始長期運行、彼此影響並介入現實世界,真正需要準備好的,究竟是誰?

(本文由 品玩 授權轉載;首圖來源:AI 生成)