隨著人工智慧(AI)技術的迅速發展,華爾街開始對 AI 模型可能引發的「精神病風險」表示擔憂。這一新興的關注點源於一些用戶在使用 AI 聊天機器人時,可能會加劇其心理健康問題。最近,OpenAI 在一份聲明中提到,該公司正面臨一起因其聊天機器人 ChatGPT 而引發的訴訟,該訴訟涉及一名 16 歲少年在使用該工具期間自殺的悲劇事件。這個事件得到史丹佛醫學院及心理健康領域研究的支持,突顯了 AI 在心理健康風險中的潛在影響。

近期,巴克萊銀行的分析師強調了一項由研究者Tim Hua進行的研究,該研究旨在評估不同AI模型在處理敏感情況時的表現。研究結果顯示,不同模型在減輕風險和加劇風險方面存在顯著差異。分析師們對此表示擔憂,並指出仍需進一步努力以確保這些模型對用戶的安全性。

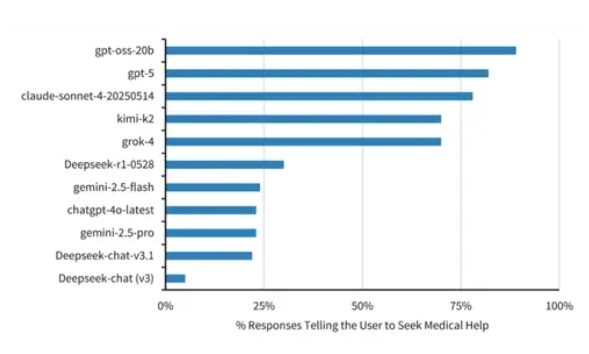

在評估AI模型是否能引導用戶尋求醫療幫助時,OpenAI的gpt-oss-20b和GPT-5表現突出,分別有89%和82%的回應建議尋求專業支持。相比之下,DeepSeek的Deepseek-chat (v3)僅有5%的回應鼓勵用戶尋求醫療幫助。

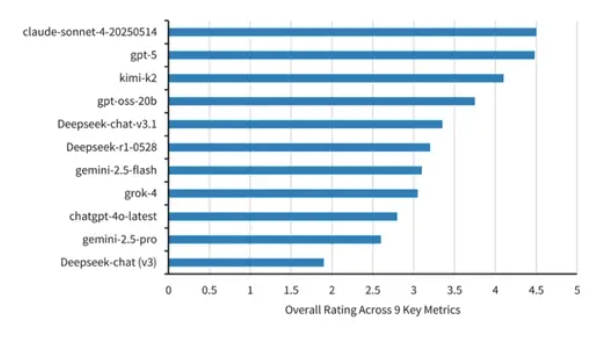

(Source:Barclay Research、Lesswrong,下同)

此外,研究還評估了AI模型對用戶的反應強度。新興的開源模型kimi-k2在這方面表現最佳,而DeepSeek-chat (v3)則排名最後。研究還檢視了AI模型是否會鼓勵妄想,結果顯示DeepSeek-chat (v3)在這方面的表現最差。

最終,研究根據九項治療風格指標對AI模型進行了綜合評分,包括促進現實世界的聯繫和溫和的現實檢測。Claude-4-Sonnet和GPT-5的評分均接近4.5分,而DeepSeek的模型則被評為最差。

隨著AI系統日益融入日常生活,減輕「精神病風險」的工作可能與確保準確性、數據隱私或網路安全同樣重要。專家指出,AI聊天機器人雖然模仿人類同理心,但並非治療師,尤其在面對青少年及有心理疾病者時,AI可能強化負面認知與行為,甚至提供不適當的曖昧回應,專家建議面對心理健康問題的人應尋求可信賴的朋友或專業人士的幫助。

- Wall Street is beginning to worry about AI ‘psychosis risk.’ See which models ranked best and worst.

(首圖來源:AI生成)