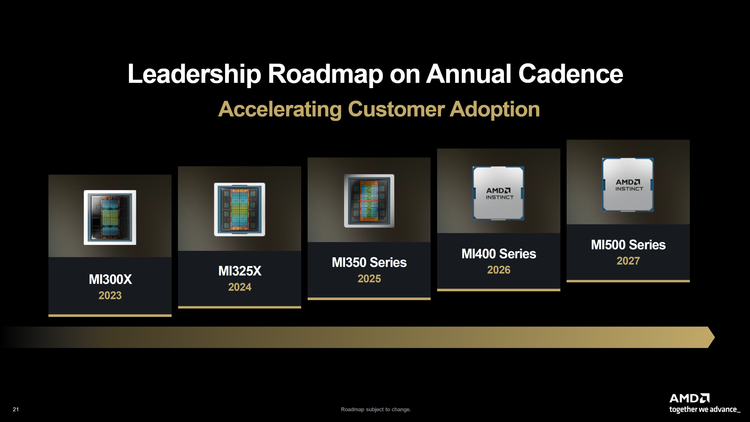

AMD 在 CES 2026 舞出一場超級秀,OpenAI 總裁葛雷格·布羅克曼(Greg Brockman)罕見為競爭對手背書,李飛飛的 World Labs 深度綁定 AMD 算力,Blue Origin 宣布用 AMD 晶片登月。硬體層面,蘇姿丰公布了未來兩年三代 GPU 路線圖──MI455X(2026 年底)、MI500(2027 年)連續迭代,性能每代提升倍數級,劍指輝達 AI 晶片霸主地位。

重量級路線圖:兩年連發三代AI晶片

2026年底:MI455X領銜Helios平台

AMD發布的Helios是新一代機架級AI系統,雙機架設計、重達7,000磅(約3.2噸)。單機架整合72顆MI455X GPU,提供2.9 ExaFLOPs算力、31TB HBM4記憶體,並具備約43 TB/s的scale-out(跨機架)頻寬與約260 TB/s的scale-up(機架內)互聯頻寬。

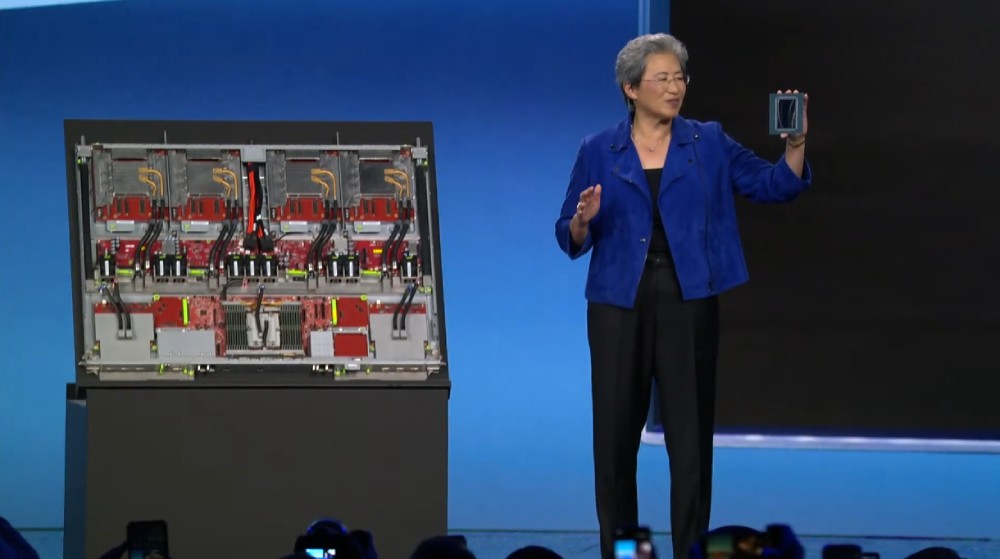

MI455X採用2nm+3nm混合製程,首次搭載HBM4,性能相比目前的MI355X提升10倍。蘇姿丰在台上舉起實體晶片時強調:「這東西美不美?」同步發布的還有MI440X(針對8卡配置)和MI430X(主權雲和傳統HPC場景)。

(Source:影片截圖)

2027年:MI500系列接力

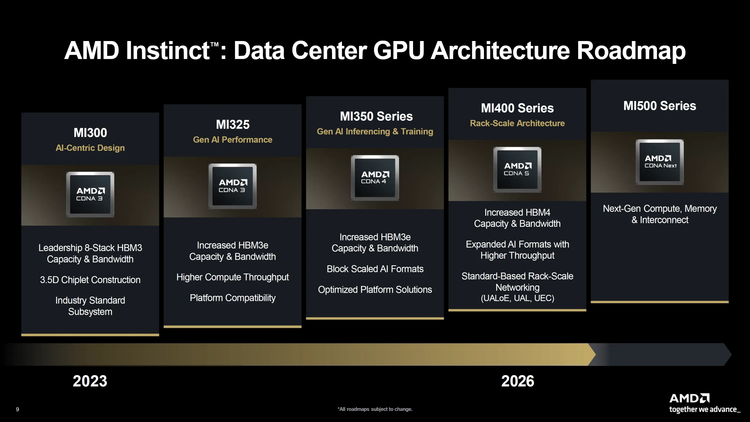

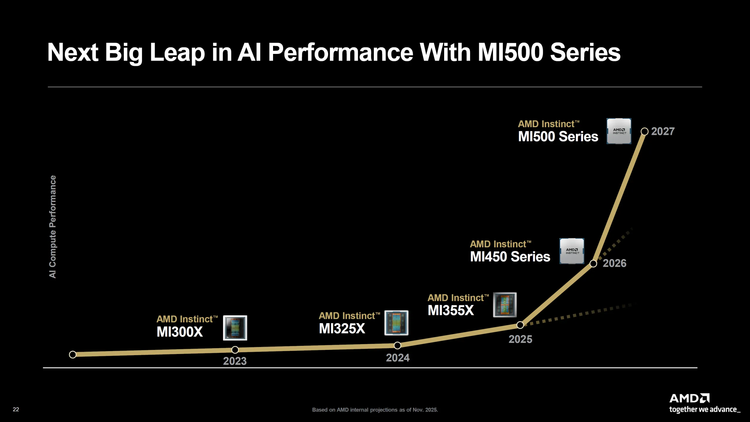

更關鍵的是AMD首次公布了完整的Instinct路線圖,明確展示到MI500系列的技術演進:

MI500系列規格:

- 架構:CDNA 6

- 製程:2nm

- 記憶體:HBM4e(更高頻寬版本)

- 時間:2027年

這意味著AMD將保持年度迭代節奏,從MI300(2024)→ MI400系列(2026)→ MI500(2027),三代產品在兩年多時間內密集發布。相較之下,輝達的Blackwell到下一代Rubin的週期也在18-24個月,AMD正在追上競爭對手的產品節奏。

消費級:Ryzen路線同步推進

客戶端方面,AMD發表Ryzen AI 400系列(12核心Zen 5+60 TOPS NPU,1月底出貨)和Ryzen AI Halo開發者平台(128GB記憶體,本地跑2000億參數,Q2上市)。同時首次展示代號Venice的Zen 6伺服器處理器實體晶片,但未公布具體時間表。

▲ Ryzen AI Halo:能本地運行2,000億參數模型的迷你工作站。(Source:AMD)

這套路線圖的策略意圖清晰:以高頻迭代和開放生態,蠶食輝達在資料中心AI晶片逾80%的市場占有率。

OpenAI總裁罕見同台AMD:算力供給將影響未來GDP上限

Greg Brockman的現身意義重大。身為OpenAI聯合創辦人兼總裁,他過去幾乎只為自家合作夥伴(主要是微軟和輝達)站台。這次登上AMD舞台,釋放了明確訊號:OpenAI正在多元化算力供應鏈。

Brockman核心觀點有三:

- AI從「文字框」進化到「代理艦隊」──ChatGPT不再是被動回答問題的工具,而是能調用其他AI代理、長時間自主運行的複雜系統。這意味著推理算力需求將會暴增。

- 算力將成為GDP約束──「幾年後,經濟成長本身將受制於可用算力規模。AI不僅服務最終用戶,更要優化所有現有流程。」

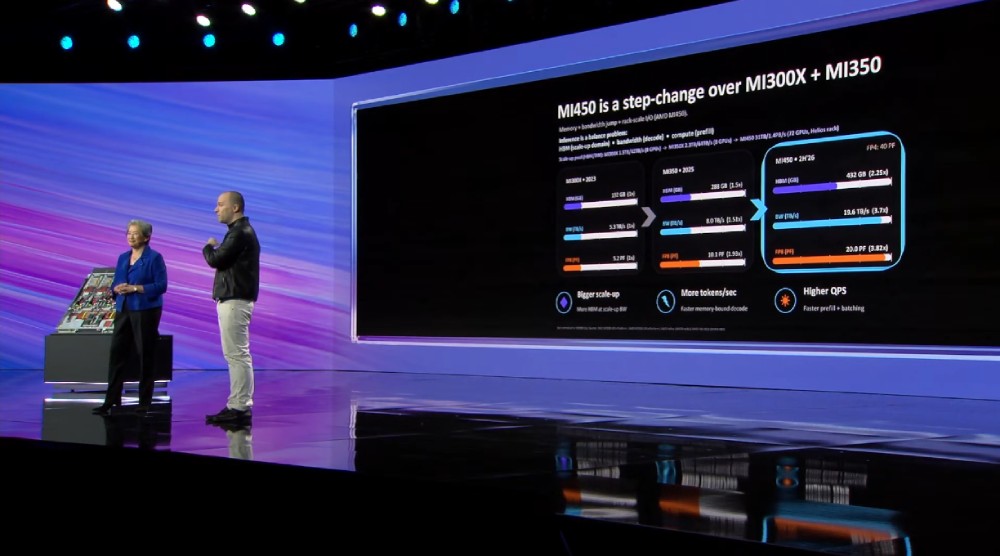

- 展示ChatGPT自動產生對比圖表──現場簡報中,AI代理僅憑原始資料就自主研究並產生MI450 vs MI300效能比較幻燈片,證明代理工作流程的實用性。

▲ ChatGPT自主產生的MI450與MI300、MI350效能比較圖。(Source:影片截圖)

更關鍵的數據來自Luma AI:這家生成影片公司CEO Amit Jain透露,其60%推理負載已在AMD上運行,並計劃將合作規模擴大10倍。 Luma的Ray3模型正是算力密集型應用的典型代表,這個案例證明AMD已經在實際商業場景中獲得頂尖客戶認可。

李飛飛押注AMD:空間智慧需極致算力

被譽為「AI教母」的李飛飛以World Labs聯合創始人兼CEO身分登台,展現了旗艦產品Marble的驚豔能力:

▲ 「AI教母」李飛飛以World Labs CEO身分登台,展示空間智慧技術。(Source:影片截圖)

光是幾張照片,Marble就能生成符合物理法則的完整3D世界。在現場展示中,從AMD辦公室的照片到可互動的三維模型,整個重建過程只需幾分鐘。這不是簡單的建模,而是AI理解空間關係、光影、物理後生成的「智慧化世界」。

李飛飛的核心觀點直指硬體需求:「你看不到的是背後需要多少運算量。推理速度越快,世界響應性就越強──即時鏡頭移動、即時編輯、場景始終連貫,這才是關鍵。」她明確表示期待MI400系列上市,以支持更大規模世界的即時渲染和互動。

World Labs已獲AMD Ventures投資,技術應用涵蓋遊戲、元宇宙、虛擬製作、建築設計等領域。從ImageNet到空間智慧,李飛飛的每次轉向都預示著AI新典範──而這次,她選擇深度綁定AMD的算力路線圖。

AMD晶片上月球:Versal 2驅動Blue Origin登陸器

Blue Origin首席技術長John Couluris宣布,其Mark 2月球著陸器將搭載AMD Versal 2晶片,用於自主降落和即時危險識別。這是典型的「終極邊緣運算場景」──延遲必須極低,算力必須可靠,且要在極端溫度和輻射環境下工作。

Couluris透露,Blue Origin員工已全員使用AI工具,未來月球探索將依賴邊緣AI提前處理和優化數據。Mark 2登陸器計畫2028年執行任務,目標是建立永久月球基地,並在月球背面進行射電天文學研究。

這個案例與AMD另一個合作同樣驚豔:Generative Bionics的Gene 1人形機器人搭載「分布式觸覺皮膚」,能感知壓力和接觸,應用於輔助物理治療。該機器人將於2026年下半年量產,核心運算由AMD處理器驅動。

從月球表面到地球上的復健中心,AMD在用硬體證明:AI不僅是雲端訓練遊戲,更是邊緣即時決策的必需品。

Liquid AI:12億參數,把「本地代理」做成可展示的產品形態

AMD還請來了Liquid AI創辦人Ramin Hasani。這家從MIT衍生的公司發布了LFM 2.5,並強調其路線是用更有效率的架構,讓十億級參數模型在本地設備上也能跑出接近大模型的體驗,把「效率」而不是「堆參數」作為核心賣點。

Hasani的表述很直接:「我們不造基礎模型,我們造液態模型。」現場他們示範了「主動代理」的工作方式:在Zoom會議中自動記錄要點,同時對電子郵件進行檢索式研究,用戶還能繼續操作表格,主打「不中斷工作流程」的並行能力。 Liquid AI也透露,計劃在2026年底推進原生多模態的下一代模型(文字+視覺+音訊),並與Zoom等場景方繼續推進產品化合作。

這一段也呼應了Ryzen AI Halo的敘事:更強的本地記憶體與端側算力,配合更有效率的模型路線,目標是把「離線也能跑的智慧代理」推向可用階段。

開放生態對抗CUDA霸權

蘇姿丰一再強調的一句話是:「AMD是唯一在全端提供開放性的公司」。這是對輝達CUDA封閉生態的正面宣戰。 ROCm開源軟體堆疊能否追平CUDA十餘年的開發者累積,決定了AMD能否真正撼動市場格局。

▲ AMD從流程、架構到記憶體技術的全面演進路線。

市場數據支撐了AMD的信心:

AI用戶從ChatGPT發布時的100萬成長到現在的10億,五年內將達50億。

全球算力需求從2022年的1 ZettaFLOP成長到2025年的100 ZettaFLOPs,五年內需要10+ YottaFLOPs,相當於2022年的10,000倍。

Luma AI、OpenAI等客戶選擇AMD,很大程度是為了降低對單一供應商的依賴和總擁有成本(TCO)。 Luma CEO直言:「推理經濟性對我們至關重要,模型需要大量算力和token」。

三大懸念:豪賭能否兌現

蘇姿丰的開場詞是「You ain’t seen nothing yet」(好戲才剛開始)。但從願景到現實,至少有三個問題待解:

- Helios能否如期交付──2026年底是關鍵節點,MI455X的10倍效能承諾能否兌現將直接影響顧客信心。

- 年度迭代能否持續──從MI400到MI500的12個月週期,對供應鏈、良率、生態適配都是巨大考驗。

- ROCm生態成熟度──開發者工具、模型適配、調試體驗能否短期內追平CUDA?這是決定勝負的軟實力。

從OpenAI總裁的罕見站台,到李飛飛World Labs的深度綁定,再到Blue Origin的月球計畫,AMD在CES 2026搭建起了全方位的AI算力敘事。但AI晶片戰爭的下半場,拚的不再是PPT和路線圖,而是真實的交付能力、生態整合能力和長期服務能力。

Helios能否準時交付?OpenAI會把多少負載遷移到AMD?李飛飛的太空智慧何時大規模商用? 2026年底到2027年的連續發布能否兌現?市場會給出答案。