OpenAI 12 日推出 GPT-5.3-Codex 精簡版——GPT-5.3-Codex-Spark,目前這款研究預覽版是 OpenAI 首款專為即時程式設計所打造的模型,更是與 AI 晶片公司 Cerebras 合作的新里程碑。

Codex-Spark 是 OpenAI 第一個專為即時搭配 Codex 使用所打造的系列模型,可進行精準修改、重塑邏輯、介面最佳化,並立即看到編碼結果。由於專為速度調校,Codex-Spark 預設採用輕量化工作風格,可進行最小且精準的修改,除非特別要求,否則不會自動執行測試。

Codex-Spark 在超低延遲硬體上運行時幾乎能帶來即時體驗,在維持真實世界程式設計任務高度表現的同時,Codex-Spark 每秒可輸出超過 1,000 詞元(token)

推出初期,Codex-Spark 擁有 128K 上下文長度、僅支援文字。在研究預覽版期間,Codex-Spark 設有獨立的使用速率限制,其使用量不計入標準速率限制。但在需求高峰,開發者可能會遇到存取受限或暫時排隊的情況

在評估代理式軟體工程能力的 2 項基準測試 SWE-Bench Pro 與 Terminal-Bench 2.0,GPT-5.3-Codex-Spark 展現強勁表現,完成任務所需時間僅是 GPT-5.3-Codex 的一小部分。

Codex-Spark 是打造 Codex 雙模式的第一步:一種將是支援長期推理與執行的模式,另一種則是支援快速迭代的即時協作模式。OpenAI 透露隨著時間演進,這 2 種模式將逐漸融合,也就是 Codex 未來能將長時間任務委派給背景執行的子代理程式,或在需要廣度與速度時,同時分配任務給多個模型,開發者無需一開始就指定單一種模式。

Rolling out today to ChatGPT Pro users in the Codex app, CLI, and IDE extension. https://t.co/Ln74zCPJqK

— OpenAI (@OpenAI) February 12, 2026

Cerebras 晶片驅動 Codex-Spark 運行

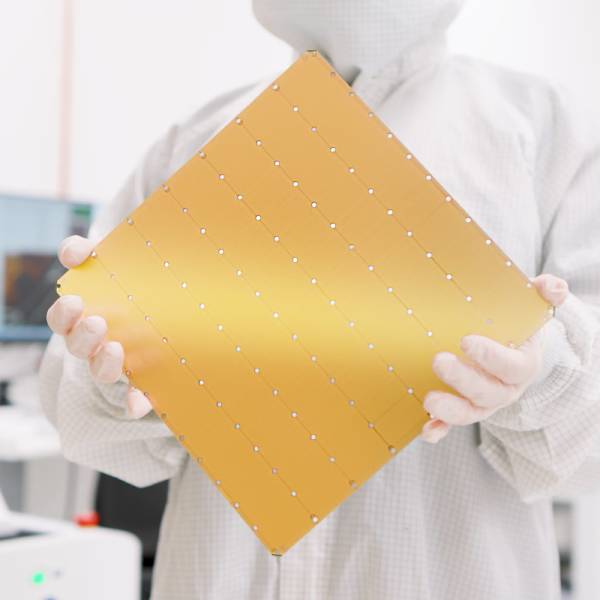

OpenAI 指出,Codex-Spark 運行在 Cerebras 的 Wafer Scale Engine 3,這是一款專為高速推論打造的 AI 加速器,為 Codex 提供低延遲優先的服務層。OpenAI 與 Cerebras 合作,將此低延遲路徑整合至與其他模型相同的生成服務堆疊,並為未來模型做好準備。

▲ Wafer Scale Engine 3。(Source:Cerebras)

「GPU 仍是我們訓練與推論流程的基礎,為廣泛使用提供最具成本效益的詞元。」OpenAI 表示,Cerebras 在極低延遲需求的工作流程表現出色,使 Codex 在迭代過程中更流暢;而 NVIDIA GPU 與 Cerebras 的 AI 加速器可在單一工作負載結合使用,以達到最佳效能。

Codex-Spark 目前以研究預覽版,在 Codex 應用程式、CLI 及 VS Code 擴充套件向 ChatGPT Pro 訂閱用戶開放使用,讓開發者開始試驗;也藉 API 向少數合作夥伴開放 Codex-Spark,從中了解開發者如何將其整合至產品當中。與此同時,OpenAI 與 Cerebras 合作擴充資料中心容量、強化端到端使用體驗,並部署更大型的先進模型。

(首圖來源:OpenAI)