住在舊金山的馬克怎麼都沒想到,兒子生病,因線上看診傳給醫生兒子隱私照片,卻讓自己差點身敗名裂。

事情發生在 2021 年初,當時疫情高峰期,一些非緊急醫療機構都停止服務,也包括馬克家的家庭醫生。馬克發現兒子生殖器腫起來,故和醫生視訊通話,通話前護理師請馬克拍一張照片先給醫生看,馬克照做,卻讓他惹上大禍。

愛子心切的父親,演算法眼中的「戀童癖」

照片傳出去兩天後,馬克突然接到 Google 通知,說他涉嫌儲存和散播有害內容,嚴重違反用戶協定和公司政策且違法,馬克的帳號將全部封鎖。由於馬克是 Google 全家方案用戶,後果相當慘重:

馬克不僅 Gmail、通訊錄、日曆不能用,還因是 Google Fi 虛擬營運商使用者,連手機號碼一起凍結了。

惡夢還沒結束。Google 不僅封帳號,還自動回報打擊兒童色情/性虐待內容的監督機構,機構又通報舊金山警局。2021 年底警方向 Google 調閱馬克資料,對馬克展開調查。而長達一年馬克面臨「戀童癖」指控,工作生活都停擺,幾乎身敗名裂。

《紐約時報》報導使馬克處於如此尷尬境地的,正是 Google 鮮為人知的兒童性虐待打擊系統。美國政府定義兒童性虐待內容(Child Sexual Abuse Material,CSAM)包括照片、影片等,只要涉及未成年人露骨色情畫面,都屬此類。更具體說,涉及誘騙、勒索、展示/鼓動/宣揚性化(sexualization)未成年人、拐賣兒童內容,都屬 Google 明令禁止的 CSAM 範圍。

(Source:Google)

為了防止平台、產品和技術傳播 CSAM,Google 投入大量資源掃描、阻止、移除和舉報 CSAM──但這次讓馬克遭殃的並不是 Google 搜尋技術,而是 Google 人工查驗流程有疏漏。

各大公司 CSAM 檢索和事後舉報流程,都包括演算法掃描和人工查驗雙重保險系統,Google 也不免俗。然而馬克這例子是演算法發現照片,自動觸發系統鎖上馬克帳號,交由人工查驗後,審查員似乎沒考慮事發背景,未發現這張照片是傳給醫療專業人士。事後馬克立即申訴,然而 Google 不僅拒絕複審,甚至不讓他先下載自己的資料。封鎖帳號的所有資料兩個月後會自動刪除,故馬克損失了多年積累的各樣檔案。

事情就這樣拖過一年,去年底警方才開始調查。一年來馬克幾近「社死」,很難跟同事和朋友老實解釋手機號碼、信箱為什麼憑空消失。直到今年初,警方才完成調查結案。

結果毫無意外:馬克無罪。

把忠實用戶推入深淵,Google 以法律為擋箭牌解釋,合情合理卻綿軟無力。發言人表示,美國兒童保護法要求 Google 這種公司必須發現 CSAM 馬上回報。Google 透明度報告僅 2021 年度就屏蔽近 120 萬個 CSAM 嫌疑的超連結,向美國相關監督機構全國失蹤與受虐兒童服務中心(NCMEC)提交 87 萬次報告,涉及約 670 萬條內容,封鎖約 27 萬個帳號。

遺憾的是,馬克就是那 27 萬分之一。身處 27 萬人群內,就像進監獄卻高喊無辜的人,有苦說不出,說了也沒人信的滋味,簡直無法想像。

好心辦壞事

打擊 CSAM 的頁面介紹,Google 稱公司組織並訓練團隊,使用最尖端技術辨識 CSAM。美國大公司檢索 CSAM 有兩種技術:雜湊函式比對和電腦視覺辨識。

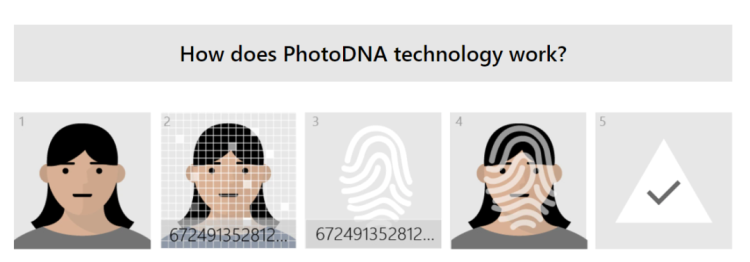

雜湊函式比對較簡單,就是取第三方機構資料庫條目和平台圖片比較,檢測是否有 CSAM 內容。早年 Google 曾用微軟 PhotoDNA 資料庫,不只 Google,Meta、Reddit、Twitter 等,CSAM 領域權威公共監督機構 NCMEC 都有使用。

(Source:微軟)

YouTube 也在使用自研 CSAI Match 技術的串流影音雜湊函式比對。當然每天都有大量違法圖片和影片誕生,所以除了雜湊函式比對,Google 還自研部署基於電腦視覺辨識的機器學習分類器,檢索未見過的內容。Google 將技術整合到 Content Safety API,開放第三方使用,Meta、Reddit、Adobe、雅虎等都是 Google 自研 CSAM 檢索技術的用戶和合作夥伴。

(Source:Google)

此案 Google 似乎是從馬克 Google Photos 找到有問題照片,Google Photos 是照片備份和雲端相冊服務,自有品牌及其他主流 Android 手機都有預裝。使用者 Google Photos 登入 Google 帳號後,會提示建議使用者打開自動上傳備份──馬克可能就是在這裡中招。如果打開自動上傳功能,除了某些第三方應用(如 Twitter、Instagram)下載的照片,相機照片及手機其他照片,都會經 Google Photos 自動上傳雲端。

官網和發言人透露,Google 不只明令限制使用者用 Google Photos 上傳和分享內容,CSAM 打擊系統也會掃描比對 Google Photos 照片。問題在 Google 發言人敘述,CSAM 打擊系統對象僅限使用者「主動行為」(affirmative action)的圖片。實際角度看,馬克開啟 Google Photos 自動上傳,是急著讓兒子看病,拍照自動上傳後忘了刪,被 Google 發現──這樣也算主動行為有點牽強。

掃描 CSAM 能保護兒童安全,有效打擊戀童癖和犯罪者,聽起來怎樣都是好事。然而近年美國大型網路科技公司做這件事時各種問題醜聞不斷──結果就是,演算法自動化打擊 CSAM 技術道德和隱私權都引起巨大爭議。如果把 Google 這次烏龍事件稱為「人禍」,去年同時間蘋果事故就可稱得上「天災」了。

去年8月初蘋果突然宣布,將在 iOS 推出專門掃描 CSAM 的用戶端工具。

(Source:蘋果)

關鍵在「用戶端」:和 Google 掃描雲端伺服器內容不同,蘋果表示只會在用戶設備做這件事,系統會下載 NCMEC 資料庫,然後完全在本地比對雜湊函式。但蘋果「用戶端」、「注重隱私」等只是表面說辭,有專家發現,使用者發送到 iCloud 儲存的照片也會成為檢測對象。還有研究者發現蘋果的比對演算法 NeuralHash 有缺陷,技術不是即將推出,而是好久前就偷偷植入 iOS,蘋果還混淆 API 名稱以便「隱姓埋名」。

蘋果宣布後不到一個月,就有人檢驗 NeuralHash 演算法會造成雜湊碰撞和「原像攻擊」。

簡單來說,雜湊碰撞就是找到兩張雜湊函式相同的隨機照片,原像攻擊則是「刻意生成的碰撞」,也即先決定用某張照片,然後生成另一張和前者雜湊函式相同但內容不同的照片。有人直接在廣受歡迎的 ImageNet 標註圖像資料庫找到幾對天然 NeuralHash「雙胞胎」(不同的原視圖雜湊函式卻相同),攻擊結果從原理和邏輯都直接推翻蘋果 CSAM 檢索技術,使其一文不值。

(Source:Cory Cornelius)

早期測試結果顯示,NeuralHash 雜湊碰撞發生率和蘋果宣稱誤報率差不多,屬可接受範圍。然而考慮到蘋果全球有超過 15 億台設備,基數太龐大,若 NeuralHash 誤報,甚至雜湊碰撞導致出事,都會波及大量使用者。

總體來看,Google、蘋果兩大行動平台公司對找尋和打擊兒童色情都有努力做事,也值得鼓勵,然另一面卻大為遺憾:因一張隨手拍的照片,工作和生活陷入僵局,甚至險些身敗名裂,這恐怕是馬克及不少和他經歷相似的人沒預料到的。這也是整件事的尷尬之處:在美國科技公司和不完善的演算法面前,好心真的可能做壞事。

(本文由 品玩 授權轉載;首圖來源:shutterstock)