2025 年 OCP 高峰會,Celestica 與博通高層以「以 1.6T 網路技術實現大規模驅動 AI」(Driving Al at Scale with 1.6T Networking)探討目前技術瓶頸,以及博通和 Celestica 的解決方案。

博通軟體產品主管 Hasan Siraj 指出,在 ChatGPT 尚未推出時,許多超大規模雲端服務商表示「網路」成為瓶頸,尤其是 AI 負載的困境。隨著 AI 模型越來越複雜,不只參數量變重要,模型也轉往多模態(multimodal),因此對算力的渴求是不會衰退的。

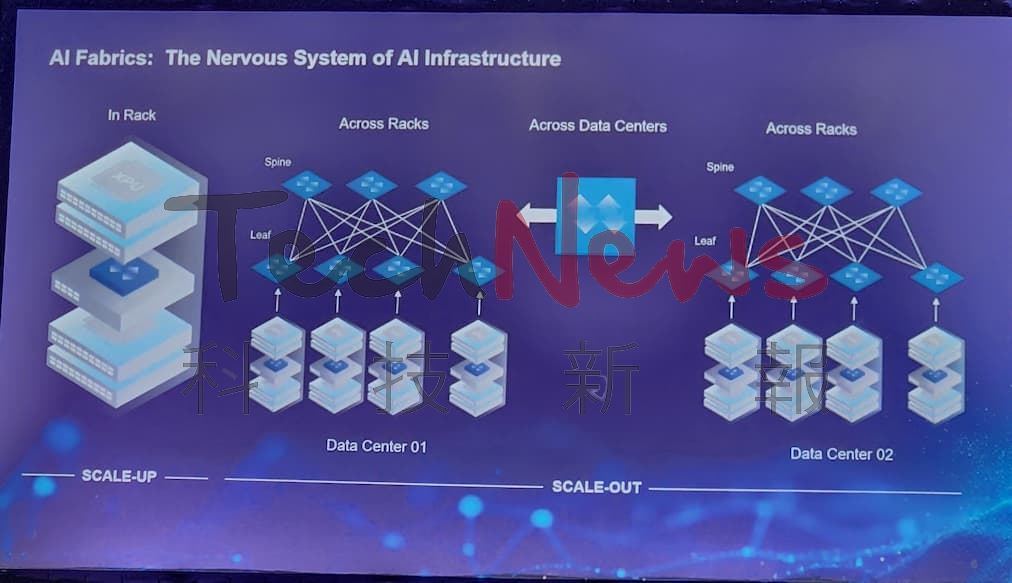

Siraj 也預期,未來三到五年內,將出現一個擁有 100 萬個 XPU 的超級電腦與超級叢集,這也使網路越來越重要,因為 AI 本身是分散式運算系統。他進一步解釋,當建設雲端資料中心時,會切割大量 CPU 資源,分別運行不同的應用程式,由於 AI 模型運作無法只依靠幾個 GPU 和 CPU 核心運作,而是需要數十萬個運算單元彼此緊密連接,才能進行大規模訓練,這也是網路之所以關鍵的原因。

而這個網路,必須具備精確的負載平衡、適當的擁塞控制、可靠的故障切換機制,且在任何情況下都不能犧牲性能與吞吐量,才能確保最佳的工作完成時間。

大規模部署 AI 叢集面臨什麼挑戰?

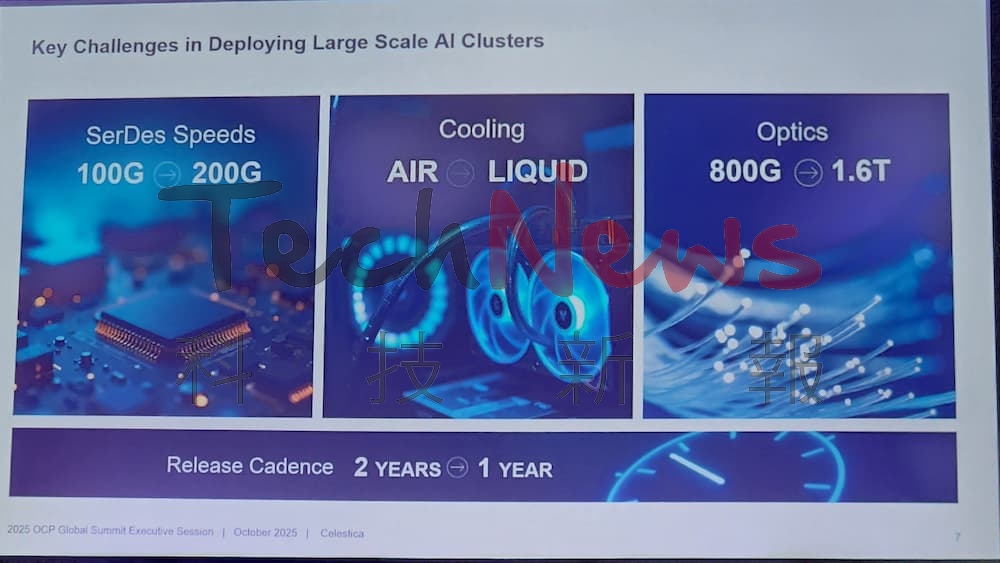

AI 擴展主要分成 Scale-Up、Scale-Out 以及 Scale-Across,談到大規模部署 AI 叢集所面臨的挑戰。Celestica 市場技術副總裁 Tareq Bustami 指出,首先是解決物理問題的龐大規模,如 SerDes 的速度要走到 200GHz,且訊號必須相當穩定;再來是散熱,目前已從氣冷解決方案開始轉往液冷散熱,2026 年將是成果顯著的一代;最後是光通訊,如今透過共封裝光學(CPO)將光學元件更緊密地整合至晶片級封裝(chiplet),雖然相當複雜性,但也見證到進展。

Bustami 也強調,所有技術創新都必須在一年內完成,因此「速度」是關鍵。為了加快開發進程,必須提前透過軟體模擬啟動軟體開發週期,同時製作機械樣品進行翹曲分析也很重要。而要解決這些挑戰,核心在於「開放標準」(open standards)。他以 Linux 為例,Linux 從誕生到被廣泛採用,花了將近十年;如今以 Linux 為基礎的 SONiC 網路作業系統,也歷經多年演進,才逐步在大規模架構中被部署。

對軟體、生態系、標準等最新進展有何看法?

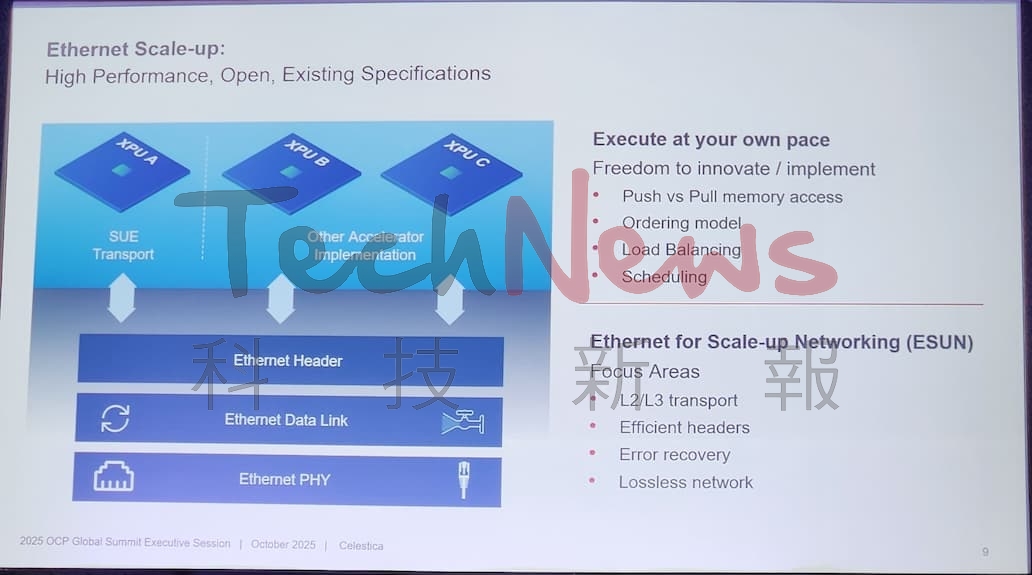

Siraj 指出,目前業界已達成共識,乙太網是建構 Scale-Up 網路的正確道路,UEC(超乙太網路聯盟)已有約 126 家企業、超過 2,000 名成員參與。雖然現階段部分專有技術在 Scale-Up 架構中表現良好,但若要支撐 AI 產業持續擴張、推動更多資料中心建設,唯有依循「開放生態系」才能實現。

也因此,OCP 昨日啟動 ESUN(Ethernet for Scale-Up Networking)聯盟,參與其中的包括 12 家主要產業龍頭,甚至涵蓋部分最大型的雲端服務商(hyperscaler)及自研 XPU 的公司。

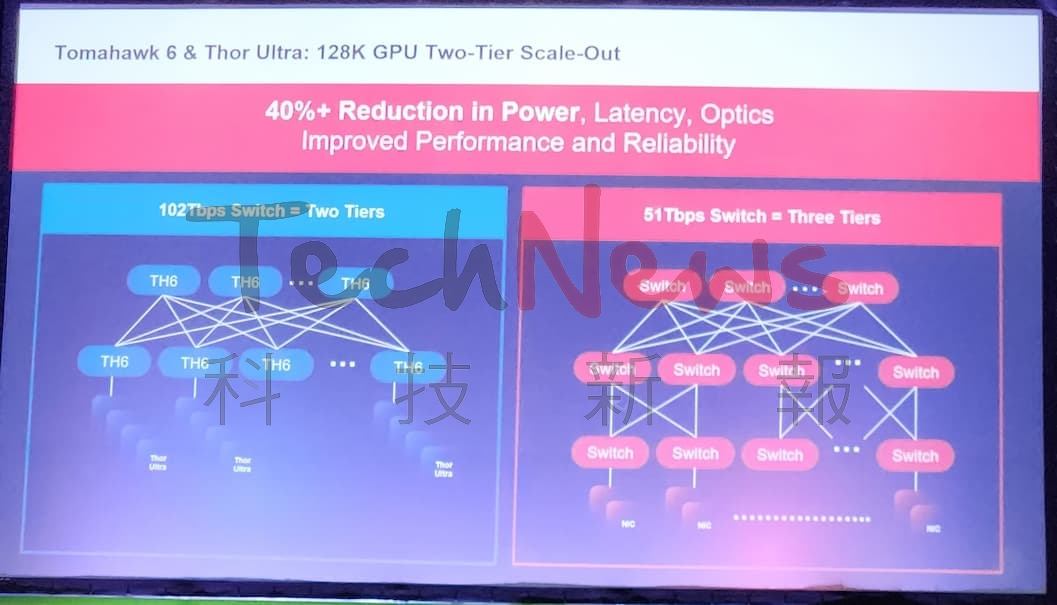

博通則於今年 6 月開始量產 Tomahawk 6,這是業界首個 100 Tbps 交換器,明年初就會看到生產;同時也發表業界首款 800G NIC 晶片「Thor Ultra」。 Siraj 表示,使用者可將多達 128 個 800G NIC 直接連接至 Tomahawk 6,並提供多種外形規格(form factor)以符合不同應用。此外,該 NIC 亦能相容於其他廠商的交換器,例如 NVIDIA 或 Cisco,在跨品牌環境下依然可維持完整功能,不會發生降級或禁用情況。

Siraj 也強調,目前最大規模的 AI 叢集約擁有 15 萬個 XPU,要在雙層(two-tier)網路拓樸中建構此等規模的網路,唯一能達成的解決方案就是採用 Tomahawk 6,因為它能大幅簡化網路設計與管理。

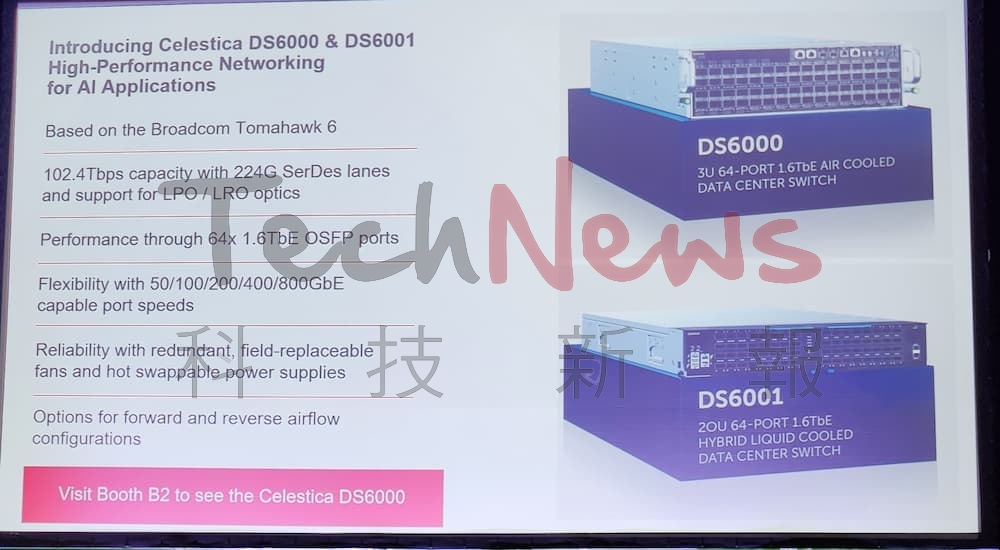

最後 Bustami 也表示,Celestica 也與博通及早期客戶緊密合作,建置了多個系統,並於近期推出兩款全新的 1.6TbE 資料中心交換機 DS6000 與 DS6001。這兩款產品均支援開源網路作業系統(NOS),以滿足高頻寬與 AI/ML 資料中心應用需求。他預期,2026 年將會是關鍵的一年。

(圖片來源:科技新報)