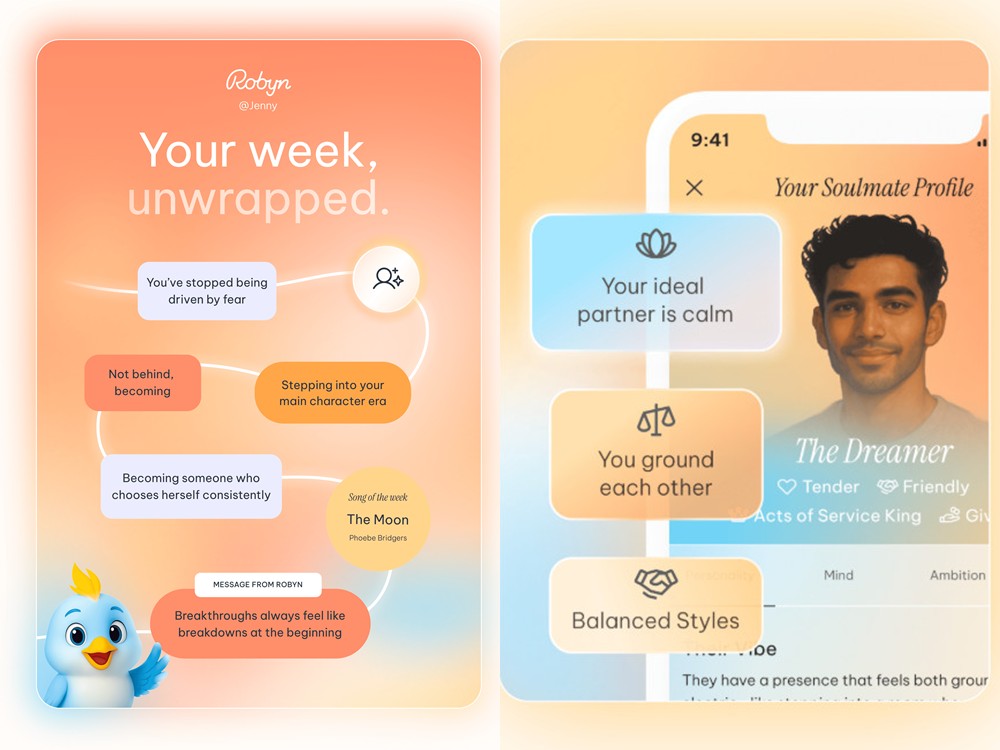

最近科技界出現了一個特別的故事。一位曾是哈佛醫師的 Jenny Shao 放下她的白袍,跑去做了一件出乎意料的事:打造了一個能「理解人類情緒」的 AI:Robyn。這個 AI 不像一般聊天機器人那樣冰冷,而是會記住你說過的話、你的壓力來源、你的生活習慣。久而久之,它甚至能像朋友一樣,在你疲累的夜裡說一句關心你的話。

這聽起來像是一種新的溫暖來源。但在溫暖之後,問題也慢慢浮上檯面。當AI開始懂我們,我們是否也應該重新思考,它能懂到什麼程度?又該懂到哪裡為止?

(Source:Robyn)

AI 可以陪伴你,但有何風險?

Robyn之所以受到關注,就是因為它不像一般的聊天機器人那樣冷冰冰。它會記得你上一週提到的焦慮,也會在你深夜情緒低落時主動關心。對於許多壓力大的上班族、無法負擔心理諮商的人,這種「永遠在網路陪伴的朋友」確實讓人心動。然而,這樣的陪伴,容易讓人產生錯覺,誤以為AI能提供真正的心理建議。當AI的語氣愈來愈像真人,安慰方式愈來愈柔軟,它就愈可能把使用者的心理依賴拉得更深。久而久之,一些本該尋求醫療協助的人,可能因為AI的陪伴而錯失了最佳治療時機。

更棘手的是,AI並沒有臨床責任。當它提供的安慰或建議被錯誤解讀,可能影響使用者情緒,甚至危及安全時,法律上很難追究AI或開發公司的責任。這與法律上可明確規範的醫療行為不同:AI不是醫師,也沒有專業資格,但卻實質介入了人類的心理狀態。這種「不負責任的共感」形成一種灰色地帶,讓法律既難以規範、也難以放任。換句話說,AI陪伴的溫度越高,責任界線就越模糊,而這正是未來最需要被法律重新定義的部分。

AI 記住你的心事,那你的隱私呢?

共感AI最重要的能力,就是記憶。它記住的不只是你的喜好,而是情緒起伏、壓力來源與生活模式。這樣的「深度理解」在陪伴上確實十分貼心,但這是高度敏感的資訊。情緒資料往往比姓名、電話更具風險,因為它能記住一個人的脆弱點、心理狀態與生活變動。如果被濫用、洩漏或做商業分析,會比一般個資更具破壞性。然而,大部分使用者在使用App時並不了解自己留下了多少資訊,也沒有意識到這些資料可能被保留多年並被反覆利用。

使用者實際上可能根本沒有真正自主決定資料的能力,因為許多AI服務的條款冗長而複雜,一般人很難在同意前真正理解資料用途。當AI能從聊天中蒐集隱私、情緒反應、甚至價值觀傾向,使用者往往連自己提供了什麼都不清楚。這種資訊不對等,使得AI開發者比使用者更了解使用者本身,形成了一種新的權力不平衡。未來的隱私保護,不再只是保障「資料不外洩」,而是保障「使用者對自己的情緒資料,保有真正的自主權」。

AI 可以越來越像你,數位人格的界線在哪裡?

隨著AI的共感能力提高,它不只是記住你,還會開始「像你」。你的語氣、偏好、回應方式,都會慢慢被AI學習並演算成一個模式。這個模式雖然不完全等於你,但已經像某種「心理剪影」。當AI不只是工具,而是以「你」的方式行動時,我們就必須問:這個「數位的你」,應該歸誰所有?

如果這個數位人格是由你的情緒資料訓練出來的,那麼你是否有權要求刪除?是否能限制平台使用?如果平台用你的「情緒模型」推算其他人的狀態,甚至生成新的AI角色,那是否侵犯了你的主體性?這些問題目前都沒有法律上的標準答案,但卻逐漸成為現實。未來,「人格權」是否應延伸到數位領域,保護人類的心理表徵不被濫用,是法律界勢必面對的一項重大挑戰。

AI 能陪伴,但真正的自由與尊嚴仍需法律守護

當AI成為生活的一部分,甚至參與我們的心理活動時,它就不再是單純的工具,而是介入人類選擇的參與者。未來的科技發展方向,或許不是避免AI變得「太有人性」,而是確保人類始終保有選擇權。法律需要保護的是:資料透明、同意真實、風險揭露、責任明確。

當使用者能夠清楚知道AI如何理解自己、用哪些方式記錄自己、又會如何使用這些資料時,科技才能在尊重人的前提下前進。共感AI的出現,提醒我們:陪伴可以委託給科技,但自由與尊嚴,永遠都應掌握在自己手中。

(首圖來源:pixabay)