Google 專為 AI 運算量身打造的 TPU(Tensor Processing Unit)已經來到第七代「Ironwood」,將在未來數週內全面供應客戶使用。

使用 Ironwood,Google 可在單一 Pod 擴展至 9,216 顆晶片,並以突破性的晶片間互連(Inter-Chip Interconnect,ICI)網路達到 9.6 Tb/s 傳輸速度。這允許數千顆晶片快速互連並存取高達 1.77 PB 的共享高頻寬記憶體(HBM),即使是最高要求的模型也能克服數據瓶頸。這也意味著 Ironwood 的 Pod 在 FP8 精度下,可比第二接近的競爭對手多 118 倍的 ExaFLOPS。

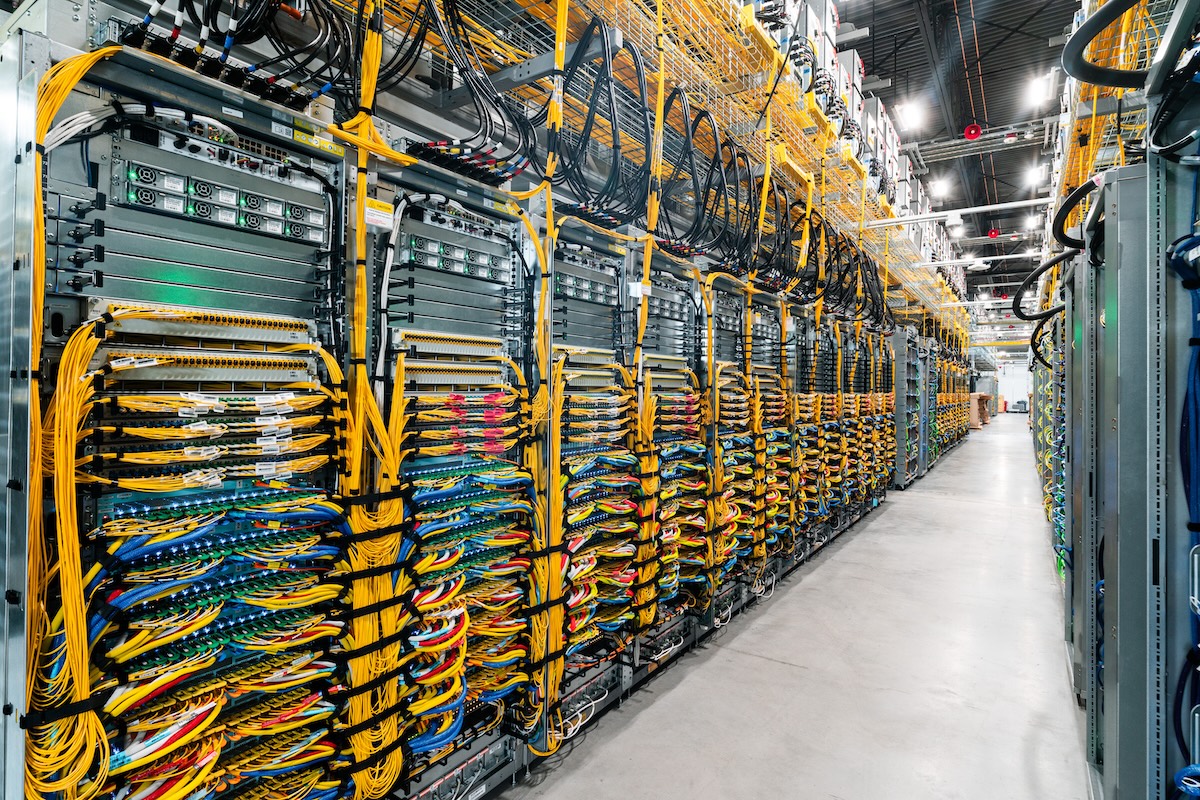

在這種規模下,服務需要不間斷的可用性。因此 Google 的光學電路交換(Optical Circuit Switching,OCS)技術作為一種動態、可重新配置的網路機制,能即時繞過中斷來恢復工作負載,確保服務持續運行。當需要更多算力時,Ironwood 可跨 Pod 擴展至數十萬顆 TPU 的叢集。

Google 以多年經驗開發出整合式 AI Hypercomputer 架構,無縫整合 AI 工作負載所需的軟硬體。TPU 已是 AI Hypercomputer 的關鍵元件,接著將由 Ironwood 接下重任。

值得一提的是,Anthropic 日前宣布擴大使用 Google Cloud 的技術,其中 TPU 用量擴充至 100 萬顆,加速他們從訓練 Claude 模型到為數百萬用戶提供服務的進程。Anthropic 正在對 Ironwood 進行測試,「Ironwood 在推理性能和訓練方面的改進有效擴展整個規模,同時保持客戶期望的速度和可靠性」,Anthropic 運算部門傑出工程師 James Bradbury 表示。

▲ 運用 Jupiter 資料中心網路技術,可將多個 Ironwood superpod 串連成數十萬個 TPU 的叢集。

▲ 第三代冷卻分配裝置(CDU),為 Ironwood superpod 提供液冷散熱。

擴充 Axion 產品組合

除 Ironwood 外,Google 進一步擴充 Axion 產品組合,這是專為資料中心設計的 Arm 架構 CPU。

Google 第二款通用 Axion 虛擬機 N4A 提供預覽,它適合微服務、容器化應用、開源資料庫、批次處理、資料分析、開發環境、實驗、數據準備以及使 AI 應用成為可行的網頁服務等工作負載。

還有 Google 首款以 Arm 架構為基礎的裸機執行個體 C4A metal 同樣提供預覽,提供專用實體伺服器以支援特殊工作負載,例如 Android 開發、汽車車載系統、具有嚴格授權需求的軟體、規模化測試平台或執行複雜模擬等等。

於是 Axion 系列包含 N4A、C4A、C4A metal 三種選項,C 與 N 系列可協同運作,讓客戶在不犧牲效能或特定工作負載需求的前提下,降低整體營運成本。

▲ Axion 為客製化、以 Arm Neoverse 為基礎的 CPU。

當 Ironwood 這樣的專用加速器處理模型等複雜任務時,Axion 則在營運骨幹方面表現出色,支援大量的資料預處理、資料擷取,以及承載智慧型應用的伺服器,Axion 開始轉化成客戶端的實際效益。

(圖片來源:Google)