因應 AI 大模型高速發展,Google、NVIDIA、Meta 積極投入 AI 加速器,其中 Google 2015 年就研發專為 AI 設計的 ASIC(特殊應用積體電路)晶片,這是 Google 透過自研張量處理單元(Tensor Processing Unit,TPU)減少對輝達圖形處理單元(Graphics Processing Unit,GPU)的依賴。

TPU 是 Google 專為 AI 訓練與推論打造的 ASIC 晶片,專門優化大型神經網路訓練、文字與影像生成、生成式 AI 的快速推論,相較 GPU 在矩陣運算效率更高,低功耗運算架構也更精準,並完全與 Google Cloud 及 Gemini 生態系整合,至今 Gemini 模型 75% 運算工作已由 TPU 執行。

Google Cloud 最新推出第七代 TPU「Ironwood」,專為生成式 AI 推理設計,支援高達 9,216 顆液冷晶片,效能比前代提升 10 倍,每瓦效能提升近 2 倍,隨著 Google 持續擴建 TPU 伺服器集群,相關供應鏈的需求跟著大幅上升,而台灣 TPU 概念股成為最直接的受益者之一。

從供應鏈角度來看,TPU 涉及晶片製造、先進封裝、伺服器機櫃製造、PCB 與高速材料,以及伺服器零組件等多個環節,其中晶片部分依靠先進製程的代工廠生產,再透過 CoWoS、InFO 或 2.5D / 3D 封裝技術完成,而散熱模組、電源及光通訊模組則是伺服器運行不可或缺的零組件。

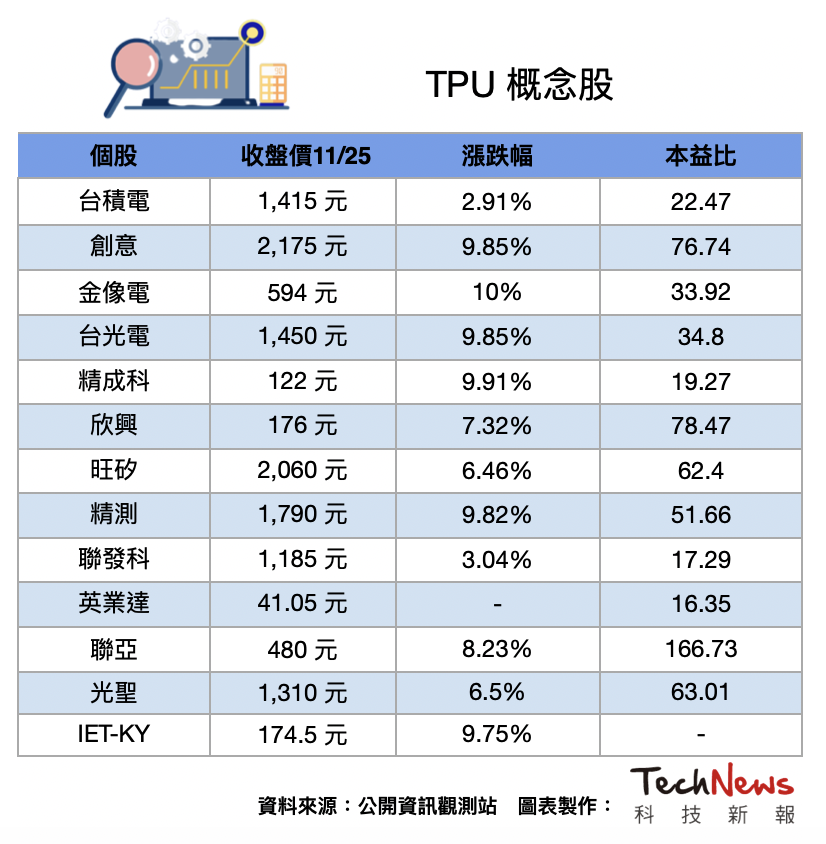

法人表示,台廠的 TPU 供應鏈中,台積電無疑是晶片代工的龍頭,負責 Google TPU 的 7nm 和 5nm 製程,再來是 Google Axion CPU 製程設計服務合作商創意,目前參與 Google 與 Meta 等多家 CSP ASIC 設計專案,預計將在 2026 年放大量。

法人點名,Google 第七代 TPU 主板設計採用 30~40 層高階 PCB,並導入 M7~M8 等級材料,金像電為平台主力供應商之一,而 TPU 平台高頻高速訊號設計需仰賴高階 CCL 材料,台光電為主要 M7~M8 供應廠之一,還有精成科併購日商 Lincstech,相當於間接切入 Google 供應鏈。

法人指出,供應 Google 伺服器載板的欣興、第七代 TPU 平台測驗階段主要供應商旺矽、精測、聯亞,以及與 Google 合作開發第七代 TPU 的聯發科,甚至是第六代 TPU 第二大供貨廠英業達,還有 TPU 高速傳輸供應商光聖、IET-KY 都將受惠。

法人認為,2026 年將是台廠全面切入 TPU 的轉折年,而 Google 的 AI 資本支出是 TPU 供應鏈的主要風向標,每當 Google 的年度 CAPEX 大幅增加,TPU 的需求就會同步成長,而 TPU 伺服器的出貨量也預計將維持雙位數的年增幅,對周邊零組件來說,形成同步的外溢效應。

整體而言,TPU 概念股涵蓋晶片代工、封裝、伺服器代工、機構件、散熱、載板與光通訊等多個族群,隨著 Google 加速部署 Gemini 與資料中心,TPU 的需求可望持續成長,相關供應鏈也具備長期投資價值。

(首圖來源:google)