生活在 AI「氾濫」的時代,我們幾乎每天都能看到 AI 研究的最新進展。昨天,AI 打 DoTA 戰勝人類了;今天,AI 能自己找路了;明天,AI 能假冒人類打電話了。擔心 AI 會滅掉人類的人眼中,AI 像一隻怪物正野蠻生長,也像一支侵略軍從遠方大步逼近。

實際上你看到的進展,只是不同 AI 在特定方向的進步。雖然當前基於深度學習的 AI 熱潮已有 5、6 年了,還是沒有一個獨立的 AI,像一個獨立的人,優秀地執行多種任務。

人們形容 AI 時,通常會用這種說法:這個 AI 的智商跟 3 歲小孩差不多。智商(Intelligence quotient)簡稱 IQ,是評價人類智商的普遍標準。你有智商,我也有智商,就連 3 歲小孩也有智商。接下來問題來了:既然說 AI 跟 3 歲小孩差不多,那麼它的智商到底有多少?

得幫 AI 測測智商了。

DeepMind 要幫 AI 測 IQ

自 AlphaGo 橫空出世,AI 解決複雜、策略性的問題上,能力已得到證明。但如果想要更像「人」,AI 必須也擁有像人類的抽象理解能力。

現在 AI 的計算能力不用說了,推理能力也很強,所以只剩抽象理解能力了。Google 旗下的 AI 機構 DeepMind 認為,「基於神經網路的機器學習模型取得驚人的成績,但要衡量推理抽象概念的能力,卻非常困難。」

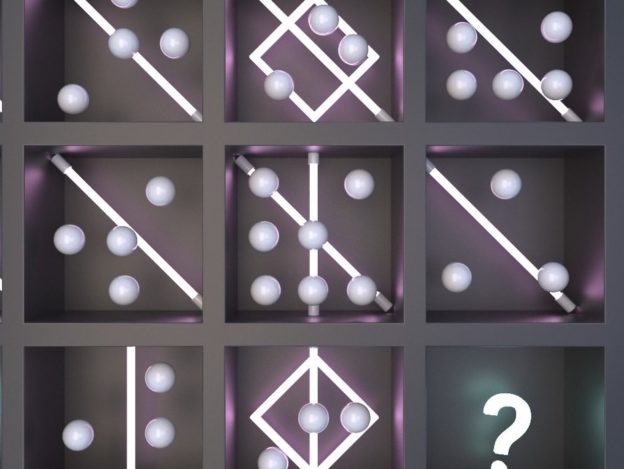

為了搞清楚現在的 AI 抽象理解能力究竟如何,DeepMind 還真的設計了一套測試題給 AI:

(Source:DeepMind)

這套測試題,借鑒人類的 IQ 測試著名的瑞文推理測驗:給一組圖片,找到符合「演進」規律的圖片。

(Source:DeepMind)

這種測試中,題目並不會告訴你要找到符合什麼標準的圖形,而是根據日常生活學習或掌握到的基本原則,來理解和分析測試出現的簡單圖案。

要找到正確的答案,往往要借鑑生活中明白的「演進」規律。比如小樹苗長成大樹,比如從 0 到 1、2、3、4、5 的加法,再比如加減乘除。以上這些,就是我們生活提煉出的抽象「演進」(progression)意義,就是人類的抽象理解能力。

「但是,我們現在還沒有找到辦法,讓 AI 也可以從『日常經驗』學到類似的能力。」DeepMind 論文說。

不過,我們依然可以利用人類的視覺抽象邏輯測試,來設計一個實驗。在這個測試,我們並不像人類測試,考察從日常生活到視覺推理問題的知識轉移。而是研究 AI 將知識從一組受控的視覺推理問題,轉移到另一組問題的能力。

簡單翻譯一下這段話就是:DeepMind 先給 AI 一組由三角形構成的圖像視覺推理題庫,等訓練差不多了,再出一組由方塊構成的視覺推理題,讓 AI 去回答,看它是能隨機應變舉一反三,還是學會三角,換成方塊就不靈了。

機器人仍需努力

對於擔心 AI 取代人類的朋友來說,DeepMind 的一部分實驗結果確實是好消息:一些最棒的 AI 模型,在這個 IQ 測試的表現並不怎樣。

正如預期,當訓練集和測試集採用的抽象元素相同,多個 AI 模型都表現出超過 75% 準確率。

然而,當測試集和訓練集有變化,甚至有時只是把黑點換成較暗的淺色圓點,AI 就像無頭蒼蠅,失去了準星。

▲ 一些知名 AI 模型的表現。(Source:DeepMind)

上面這些都是深度神經網路領域的當紅炸子雞,測起智商卻沒那麼靈光了。

ResNet(Deep Residual Network),即深度殘差網路在其中一組測試僅得到 22.4% 的低分,它的提出曾被形容為 CNN(卷積神經網路)的里程碑式事件,它在網路深度比其他模型提升了 n 個量級,更重要的是它的殘差學習方式,改良了模型架構,因此一出現就秒殺眾前輩。

表現最好的 WReN 模型,則是 DeepMind 在關係網路(Relation Networks)模型基礎上改良的版本。它增加了分析不同圖像組合之間的關係,並可評估這類 IQ 測試的各種可能性結果。

不過,DeepMind 針對這個測試的邏輯,改良一些模型,改良後的模型表現明顯有提升。

比如,在一些模型中,DeepMind 加入了標記(meta-targets)輔助訓練法,讓模型預測數據集背後體現出的形狀、屬性(形狀的數量、大小、顏色深淺等)及關係(同時出現、遞減、遞增等),當這部分預測準確,最終回答的準確率就明顯提升;預測錯誤時,回答準確率明顯下降。一些極端情況下,模型回答的準確率更從預測錯誤時的 32% 提升至 87%。

▲ 標記預測準確度與最終答案準確率的關係圖。

DeepMind 表示,他們設計的實驗,最終目的並不是讓 AI 通過這種 IQ 測試,他們關注的是 AI 泛化能力。

泛化是指模型擬合以前未見過的新數據的能力,這是機器學習界的術語,你也可以粗暴理解成一個 AI 模型能否「通吃」各類場景。AI 的泛化能力越強,離什麼都能做的所謂「通用人工智慧」就越近。

DeepMind 部落格最後這樣說:

研究表明,尋找關於泛化問題的普遍結論可能沒有任何意義。我們測試的神經網路在某些泛化方案表現優秀,但是在其他方案卻很糟糕。

諸如使用模型的架構、模型是否被訓練進而解釋答案背後的邏輯等一系列因素,都會對泛化效果帶來影響。而在大多數情況下,當需要處理過往經驗從未涉及、完全陌生的情景時,這些 AI 的表現很糟糕。

至少現在看來,AI 還有很長的路要走啊。