AI 玩遊戲不稀奇,AI 編遊戲也不新鮮,但用 AI 建構一個支援雙人即時互動、視角一致、邏輯同步的遊戲世界,終於首次出現。以色列 Enigma Labs 團隊 5 月 9 日在 X 平台宣稱發布全球首款由 AI 生成的多人遊戲:Multiverse。

名字聽起來就像漫威出品,玩法確實夠科幻。漂移、撞車,全都同步,操作互相回應,細節還能對上幀數。遊戲裡的一切,不再靠預設劇本或實體引擎控制,而是由一個AI模型即時生成,確保兩名玩家看到的是同一個邏輯統一的世界。

Introducing Multiverse: the first AI-generated multiplayer game.

Multiplayer was the missing piece in AI-generated worlds — now it’s here. Players can interact and shape a shared AI-simulated world, in real-time.

Training and research cost < $1.5K. Run it on your own PC.

We… pic.twitter.com/qsSeP0JBvr

— Jonathan Jacobi (@j0nathanj) May 8, 2025

而且Multiverse已經全面開源:程式碼、模型和資料集、文件一應俱全,全都放到了GitHub和Hugging Face。你甚至能在自己電腦上直接運行。

Hugging Face CEO Clément Delangue也在X發文大讚:

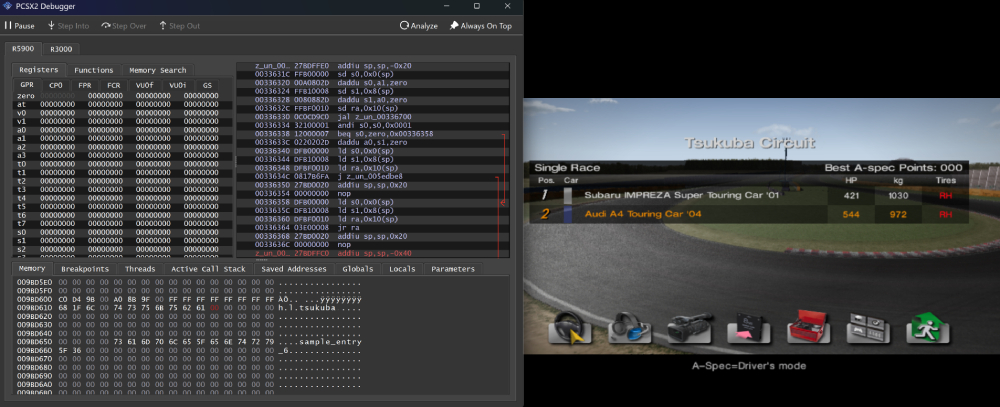

這是我今天在Hugging Face上看到的最酷的資料集:Gran Turismo 4 中1 對1 競速的動作標籤,用來訓練一個多人世界模型。

車輛在賽道上不斷變換位置,超車、漂移、加速,然後再次在某段路段匯合。

Players can overtake, drift off, speed up — and meet again. Every move reshapes the world for everyone. pic.twitter.com/WGYdShsaxU

— Jonathan Jacobi (@j0nathanj) May 8, 2025

那這款名為Multiverse的模型,究竟是怎麼一回事?官方技術團隊用一篇技術部落格分享了更多建構細節。

在此之前,我們得先介紹一下傳統AI世界模型:你操作一下,它預測一下畫面需要怎麼產生。模型看你的操作、看前幾幀,然後產生下一幀。原理也不難理解:

- 動作嵌入器:把玩家操作(例如你按了哪個鍵)轉成嵌入向量

- 去噪網路:使用擴散模型,結合操作和前幾幀畫面,預測下一幀

- 上採樣器(可選):對生成畫面進行解析度和細節增強處理

(Source:Multiverse,下同)

但一旦引入第二名玩家,問題就複雜了。

最典型的bug是,你這邊賽車才剛撞上護欄,對手那邊卻還在風馳電掣;你甩出賽道,對方根本沒看見你在哪。整個遊戲體驗就像卡了兩幀,還不同步。

而Multiverse,正是第一款能同步兩個玩家視角的AI世界模型,無論哪個玩家發生了什麼,另一個人都能實時在自己畫面中看到,毫無延遲、無邏輯衝突。

這也是過去AI模擬很難搞定的一點:多視角一致性。

要解決這一點,建立真正的協作式多人世界模型,Multiverse團隊想到了一個很聰明的方案。他們保留了核心元件,同時把原本的「單人預測」思路全打碎重構:

- 動作嵌入器:接收兩個玩家的動作,輸出一個整合了雙方操作的嵌入向量

- 去噪網絡:擴散網絡,同時產生兩個玩家的畫面,確保它們整體一致

- 上採樣器:與單人模式類似,但同時對兩個玩家的畫面進行處理和增強

本來,處理雙人畫面,很多人第一反應是分割畫面:把兩幅畫分開,各自生成。

這思路簡單粗暴,但同步難、資源耗、效果差,但他們想到將兩個玩家的視角「縫合」成一個畫面,將他們的輸入合併為一個統一的動作向量,整體當作一個「統一場景」來處理。

具體做法是通道軸堆疊:把兩個畫面當作一張擁有雙倍色彩通道的影像處理。

這技術上其實非常聰明,因為擴散模型採用的是U-Net架構,核心是卷積和反捲積,而卷積神經網路對通道維度的結構感知能力極強。

換句話說,這不是把兩個世界貼在一起,而是讓模型從「神經元底層」就知道這兩個畫面是有關聯的,是要協同生成的。最終的畫面,不用手動對齊,天然同步。

但要讓模型預測下一幀準確無誤,還得搞清楚一件事:車速和相對位置是動態的,預測得準,得有足夠的資訊。他們發現:8幀(30 fps條件下)足以學習加速、煞車、轉向等運動學特徵。

但問題在於:超車等相對速度遠比絕對速度慢很多(約100 km/h vs 5 km/h),幀數要太近,模型根本感知不到變化。

於是他們設計了一個折衷方案–稀疏採樣:

- 提供最近連續的4幀(確保即時回應)

- 再額外提供4幀「隔4幀採樣」的歷史畫面

- 最早一幀距離目前幀20幀,也就是約0.666秒前

而要真正讓模型理解「協同駕駛」,不能只靠這些輸入數據,還得在互動行為上做強化訓練。

傳統單人任務(例如走路、駕駛)只需要預測很短的時間窗口,例如0.25秒。但多人互動下,這麼點時間變化微乎其微,根本體現不出「組隊感」。

Multiverse的解法是:乾脆讓模型預測長達15秒的行為序列,以此捕捉長週期、多輪次的互動邏輯。

訓練方法也不是一下就上15秒,而是花了一套「課程式學習」(curriculum learning)策略:從0.25秒預測開始,逐步延長到15秒。這樣模型先學會汽車結構、賽道幾何這些底層特徵,再慢慢掌握玩家策略、賽局動態這些高階概念。

訓練完後,模型在物體持續性、幀間一致性方面表現明顯提升。簡而言之,不會突然車子消失,也不會前後邏輯崩壞。

如此出色的訓練表現,歸功於背後精心挑選的資料集。沒錯,就是那款2004年PS2上的神作賽車模擬遊戲:Gran Turismo 4。

當然,為了免責,Multiverse團隊也沒忘記調侃自己是索尼的鐵桿粉絲。

他們的測試場景是筑波賽道上的1對1比賽,但問題是GT4並不原生支援「1v1 視角回放」。所以他們逆向工程了一把,硬生生把遊戲改造出一個真實的1v1模式。

接著:

- 每場比賽錄兩次,一次看自己,一次看對手

- 再透過同步處理,合併為一個完整視頻,展示雙方即時對戰畫面

那按鍵資料怎麼辦,畢竟遊戲本身沒提供操作日誌。答案是,他們利用遊戲HUD顯示的資訊(油門、煞車、方向盤指示條),透過電腦視覺,逐幀提取遊戲畫面上顯示的油門、煞車、方向條,再反推出控制指令。

也就是說,全靠畫面資訊就能還原操作,無需額外日誌檔。

當然,這個流程效率偏低,總不可能每場比賽都要人工錄兩次。

他們發現GT4有個隱藏功能叫B-Spec模式,可以讓AI自己開車。於是就寫了個腳本,給AI發隨機指令,讓它自己開比賽、自己撞車,批次生成資料集。

順便,他們也試過用OpenPilot的自動駕駛模型控制遊戲角色,雖然效果不錯,但就效率和穩定性而言,B-Spec更適合做大規模訓練。

重點來了,談效果、不談成本,自然是耍流氓。這麼多能跑多視角世界、畫面同步、穩定輸出的AI模型,模型、訓練、資料、推理全算上,全程只花了1,500美元,跟買台高階顯示卡差不多。

Multiverse員工Jonathan Jacobi在X上寫道:

我們只花了1,500美元就建造了Multiverse,關鍵不在算力,而是在技術創新。

更重要的是,Jacobi認為,多人世界模型不僅是AI玩遊戲的新方式,更是模擬技術的下一步。它解鎖了一個全新的世界:由玩家、智能體和機器人共同進化、共同塑造的動態環境。

(Source:Jonathan Jacobi)

未來,世界模型可能就像是虛擬版的真實社會:你與AI共處其中,形成真實感極強的「動態宇宙」,同時也擁有接近現實社會的複雜互動邏輯。