記憶體大廠三星(SAMSUNG)在 2025 OCP 全球高峰會中發布了其革命性的 CXL 記憶體模組(CMM)路線圖,並詳細展示了針對下一代智慧代理(Agentic AI)伺服器平台設計的異質記憶體系統架構。

三星表示,此項發表的核心在於CMM-D系列的持續擴展,目的是透過CXL技術提升資料中心及AI工作的記憶體擴展性與效率,鞏固三星在長期市場中的領導地位。

CMM-D邁向1TB容量與72GB/s頻寬

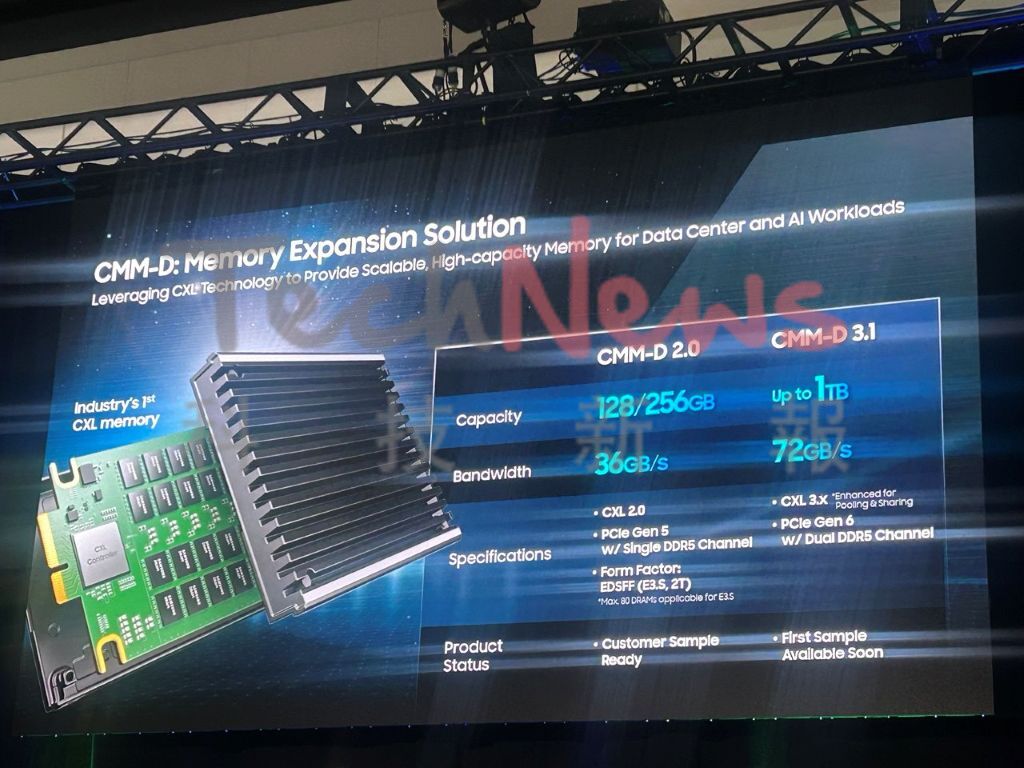

三星正在積極擴展其CMM路線圖,特別是CMM-D系列,目標是在2025年推出CMM-D終極版本,以實現商業化目標。CMM-D產品系列是業界重要的CXL記憶體擴展解決方案,為資料中心和AI工作執行提供可擴展、高容量的記憶體。

三星指出,目前的階段在CMM-D 1.1的部分,涵蓋了業界首個CXL解決方案,並使用開源韌體(Open-source firmware)。而CMM-D 2.0 則是專注於建構學習平台和提供全方位解決方案。其中,CMM-D 2.0提供128GB或256GB的容量選擇,且支援高達36GB/s的頻寬。這些產品符合CXL 2.0標準,採用PCIe Gen 5 x8介面,並支援DDR4/DDR5雙DQS通道。當前已經準備對客戶樣品。

至於,在CMM-D 3.1方面,三星的目標是透過CMM-D 3.1來實現長期的技術件展,包括預計在2025年達到設計導入,其容量可擴展至驚人的1TB,頻寬將大幅提升至72GB/s,支援CXL 3.0,特別是針對更長電纜長度的收發器(Transceiver)技術。此外,介面升級至PCIe Gen 6 x8,並持續支援DDR5雙DQS通道。而CMM-D 3.1的額外特色包括ITB、壓縮(Compression)FMM引擎。而CMM-D 3.1首批樣品即將推出。

DCMFM實現軟體定義記憶體的目標

三星還強調藉Data Center Memory Fabric Management (DCMFM) 實現軟體定義記憶體的目標。三星表示,隨著資料中心工作執行,特別是AI和Kubernetes應用方面的複雜性增加單純依賴傳統的記憶體配置方法已不足以應對。三星意識到,現有方法常過度依賴記憶體使用率預測,導致資源預測不準確、過度承諾,以及難以確切知道應用程式需要多少記憶體資源。

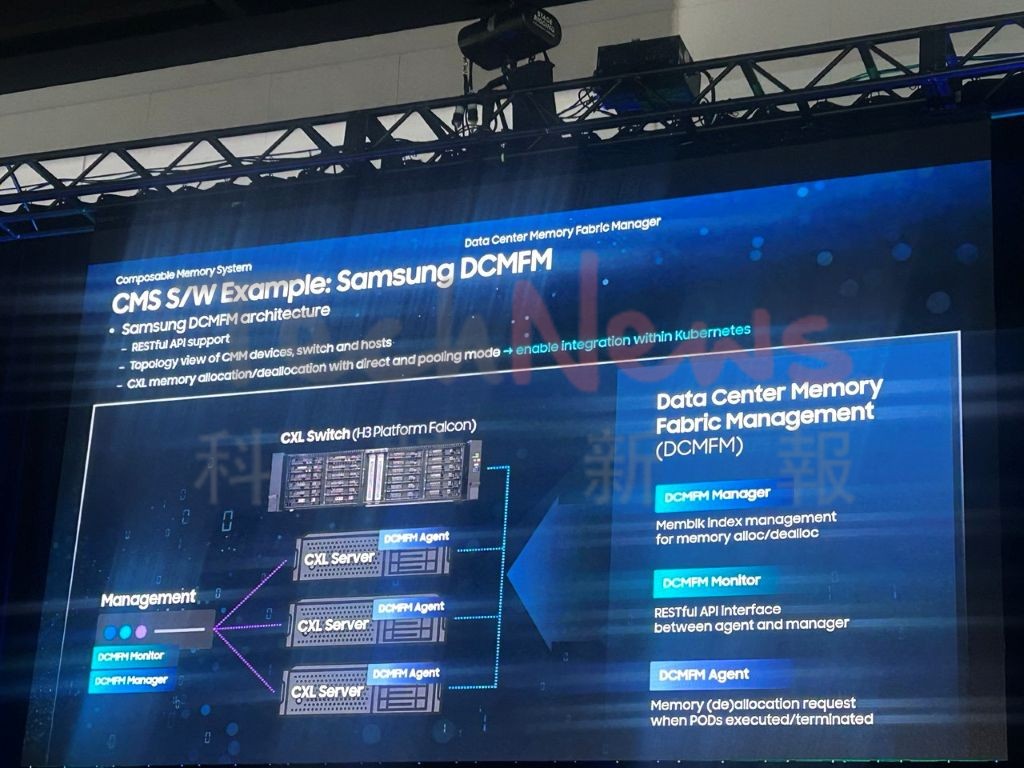

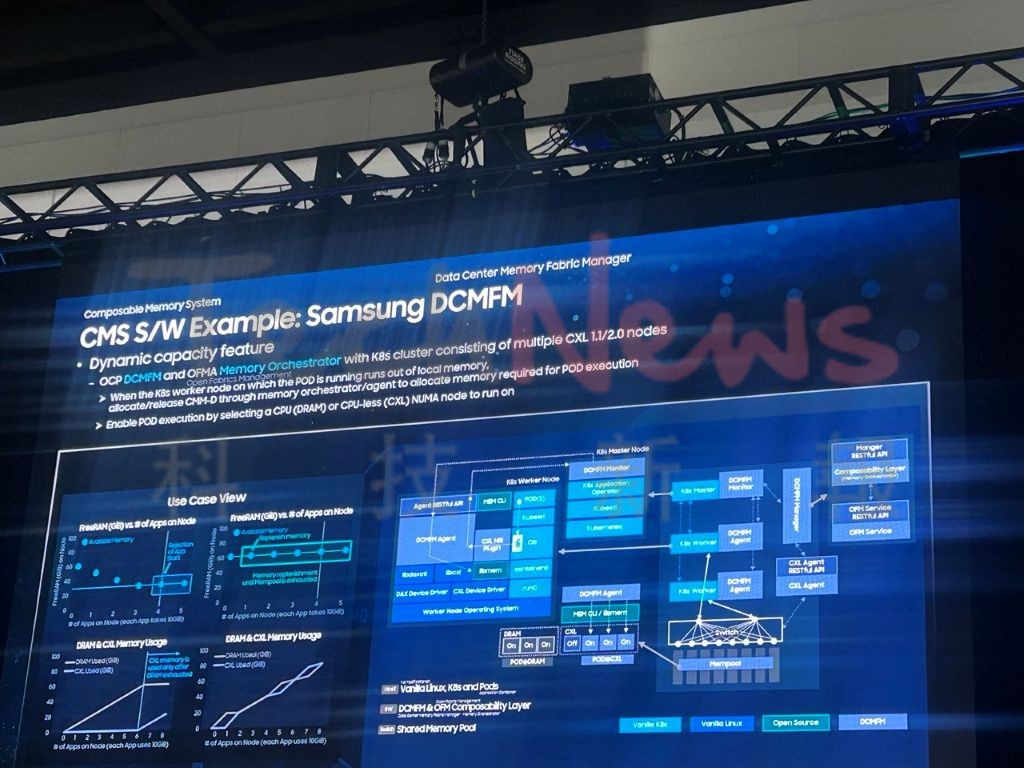

為了解決這些挑戰,三星推出了資料中心記憶體光纖管理(DCMFM)系統,做為其CMS軟體解決方案的範例。而其DCMFM架構的關鍵要素能提供集中的記憶體配置管理,用於記憶體的分配與解除分配,且系統由DCMFM Manager負責記憶體分配管理,而由DCMFM Agent負責處理來自Manager的記憶體分配請求所構成。DCMFM Monitor則用於觀察已分配/已終止的記憶體請求。

藉由以上的架構,三星強調,DCMFM能夠與Kubernetes無縫整合,提供CXL設備、交換器和主機的拓撲視圖,並支援資源解耦/重新分配,涵蓋直接連接模式和池化模式。另外,透過CMS S/W(DCMFM),三星展示了動態記憶體調整大小的範例,以應對記憶體耗盡的問題。此解決方案的成果,就是可以在最新的Vanilla X86、Linux和CXL 2.0伺服器CPU上運行。而且,還具有直接池化功能,透過VNNP到PPM的橋接技術在LD單元上達成。

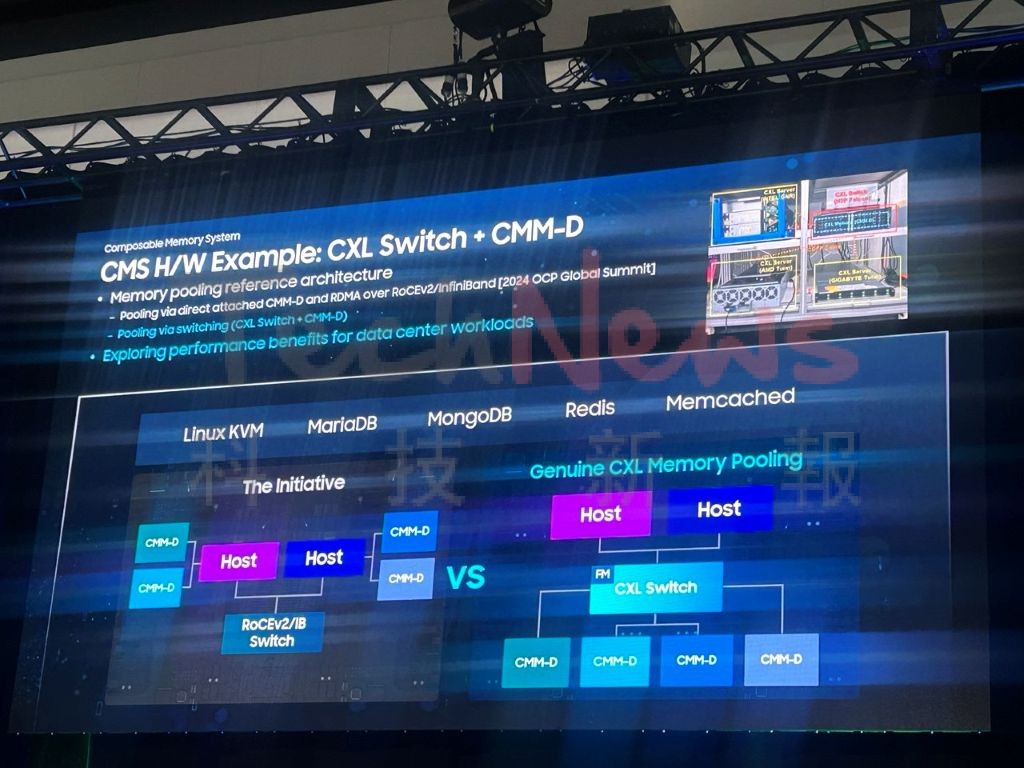

三星演示了結合CXL Switch和CMM-D的硬體架構參考設計。其中,在CXL記憶體池化的設置中,主機(Host)透過CXL Switch連接到多個CMM-D模組。這與傳統方案(Host通過Rcvd/Tx Switch連接CMM-D)形成對比。

軟體定義記憶體的需求迫切

根據雲端服務數據顯示,在2023年,AWS、Azure和Google Cloud中只有10%的預配CPU資源被利用。這突顯了資料中心在資源分配上存在巨大的浪費,因為記憶體資源通常與CPU一併預配。透過CXL技術,遠程訪問(remote access)顯著改善了記憶體利用率,並降低了相較於傳統解決方案的延遲與開銷。預計到2025年,預配CPU的使用率將從2023年的13%上升到23%。

總體而言,三星透過結合其高容量、高頻寬的CMM-D硬體路線圖與先進的DCMFM軟體管理系統,為下一代AI伺服器平台提供了一個全面的異質記憶體系統架構。這不僅解決了當前雲端資源利用率低下的問題,同時也為資料中心和AI工作負載帶來了顯著的性能提升和TCO優化。

(首圖來源:三星)