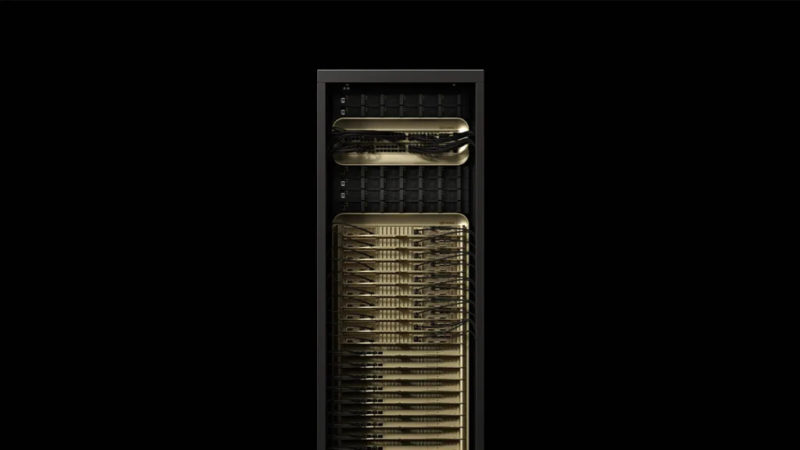

隨著大型語言模型加速導入混合專家模型(MoE)架構,AI 推論效能與成本結構成為資料中心競爭焦點。根據 Wccftech 報導,輝達 Blackwell 架構的 GB200 NVL72 AI 機櫃,在 MoE 推論工作負載下展現顯著優勢,不論在吞吐量、效能和成本表現上,皆明顯領先同級方案。

報導進一步引述 Signal65 彙整的 SemiAnalysis InferenceMAX 基準測試數據顯示,在相同叢集條件下,GB200 NVL72 於 75 tokens/sec 的推論負載中,每 GPU 吞吐量約為 AMD Instinct MI355X 的 28 倍。分析認為,這樣的差距並非來自單顆 GPU 規格,而是系統級架構設計在 MoE 場景下的整體表現差異。

Extreme Co-Design 成為 MoE 架構關鍵

報告指出,輝達能在 MoE 架構中取得領先,關鍵在於其「Extreme Co-Design」策略。GB200 NVL72 將 72 顆 Blackwell GPU 整合於單一機櫃中,並搭配高達 30TB 的高速共享記憶體(fast shared memory),使專家並行與跨節點資料交換能在低延遲、高頻寬條件下運作。

由於 MoE 模型高度依賴 all-to-all 通訊,若 GPU 之間的互連頻寬與延遲控制不足,效能將快速受限。輝達透過 NVLink 與機櫃級整合設計,降低 token 路由過程中的通訊瓶頸,使 MoE 在高互動率推論場景下仍能維持穩定效能。

MoE 是什麼?為何重要?

MoE(Mixture of Experts,混合專家模型)是一種提升模型算力效率的 AI 架構設計。其核心概念在於,模型不再於每次推論時啟用所有參數,而是透過「路由器(router)」機制,將每個 token 分派給特定的「Expert」子網路處理。

▲ Router 負責將 token 分派至最適合的專家子網路處理(Source:Cornell University)

透過僅啟用部分 Expert,MoE 能在不大幅增加實際運算量的情況下,擴大模型規模並提升推論效率,因此近年已成為大型語言模型的重要發展方向。

不過,MoE 同時也帶來新的挑戰,包括高度依賴跨 GPU 通訊、對記憶體容量要求高,以及模型訓練與微調複雜度提升等問題。

輝達如何化解 MoE 架構瓶頸

面對 MoE 對系統架構提出的高要求,輝達的策略並非僅提升單顆晶片效能,而是將設計重心放在機櫃級與系統級整合。GB200 NVL72 透過高速互連與共享記憶體架構,使大量 token 在專家之間切換時,能有效降低延遲與頻寬壓力,進一步提升整體推論效率。

在成本層面,報導指出 GB200 NVL72 在高互動率推論條件下的「每 token 成本」約為競品方案的 1/15。比較結果顯示,在 25 tokens/sec 的負載下,其效能/成本優勢約為 3.1 倍,當推論互動率提升至 75 tokens/sec,優勢更擴大至 15 倍。

相較之下,AMD 的 Instinct MI355X 仍具備高容量 HBM3e 記憶體等特性,在高度密集運算場景中具備一定競爭力。然而,在以 MoE 架構為主的推論工作負載下,分析指出其系統級整合與互連設計仍較為受限。

業界普遍認為,隨著 AI 應用持續由訓練導向推論,且模型架構朝 MoE 發展,未來競爭焦點將不再只是單顆 GPU 規格,而是機櫃級、資料中心級的整體設計能力。隨著新一代平台陸續推出,相關競爭態勢仍有待觀察。

(首圖來源:輝達)