人工智慧 (AI) 市場蓬勃發展,企業購建運算需求大增,AI 晶片一直供不應求,除了產能面臨瓶頸,搶貨也是重要原因之一。輝達 (NVIDIA ) H100 晶片最搶手,但經歷大量掃貨後,後續算力更強大的 H200 晶片即將上市,H100 晶片伺服器近期中國傳出價格下跌消息。

因缺貨加上美國出口禁令,輝達 H100 晶片伺服器搶貨最兇的中國市場也出現熱潮消退,價格下跌。較最熱烈時期,搭載 H100 晶片的伺服器中國黑市售價破 300 萬人民幣,現在下跌約一成,約 270 萬至 280 萬人民幣,價差將冒險販售的廠商利潤全部吃光。

輝達 H100 晶片伺服器跌價原因,市場人士指出,輝達新高階 AI 晶片 H200 即將問世,新舊產品交替,囤貨炒高 H100 價格的中國黑市廠商為了出清大量庫存,開始拋貨,與輝達 RTX 系列顯示卡因虛擬貨幣造成搶貨使價格暴漲一樣。又因虛擬貨幣價格暴跌,大量囤積顯卡價格暴跌,甚至論重販售,令人仍印象深刻。

除了新產品造成舊產品低價出售,供應瓶頸問題也有緩解。戴爾台灣總經理廖仁祥表示,輝達 H100 晶片等待時間,從三至四個月縮短到僅二至三個月 (8 至 12 週),伺服器代工廠也透露,2023 年幾乎無法買到 H100 AI 晶片,供應瓶頸已有緩解。

輝達規劃,第二季開賣算力更高 H200 晶片,雖然 H200 和 H100 一樣是 Hopper 架構,但性能比 H100 提升約 60%~90%。H200 升級還有記憶體容量跟頻寬,141GB HBM3e 記憶體較 H100 提升 80%,頻寬從 3.35TB/s 增至 4.8TB/s,提升 40%。

輝達 H200 AI 晶片的大語言模型 (LLM) 推理訓練性能提升顯著,以含 700 億參數的 Llama 2 大語言模型推理速度比較,H200 晶片效能較 H100 快近一倍,能耗還只有一半,讓 H200 晶片伺服器更受市場期待,中國廠商擔心 H200 問市直接打擊 H100 銷售,最終拋售庫存,使 H100 晶片伺服器價格驟跌。

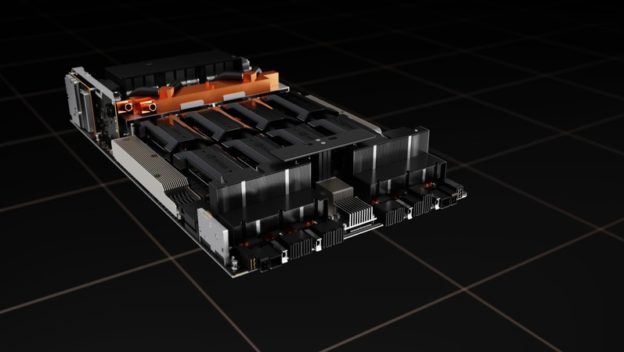

(首圖來源:輝達)