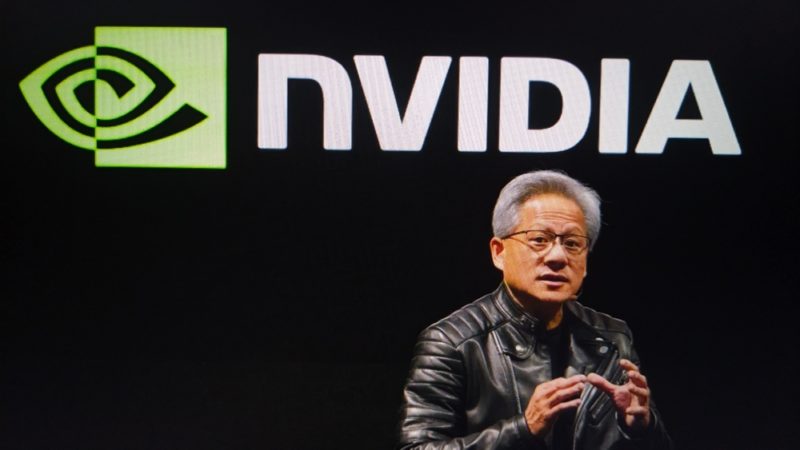

輝達(NVIDIA)執行長黃仁勳近期在 CES 2026 舉辦主題演講,而在 CES 的問答環節中,當被問到是否以 SRAM(Static Random Access Memory 靜態隨機存取記憶體)取代 HBM 時,他則認為各自有優勢。

黃仁勳表示,雖然 SRAM、較便宜的記憶體及開放權重模型可提升效率,但 AI 工作負載的不斷變化現實,使輝達仍離不開 HBM。對某些工作負載來說,SRAM 快得驚人,而 SRAM 存取可避免即便是最快外部記憶體也存在的延遲問題。

目前 SRAM 加速器、GDDR 推理,以及開放權重模型(open weight models),都被提出作為緩解 NVIDIA 成本的解決方案,但黃仁勳的回答則顯示,這些解方在單一情境下有效,但一旦面對大規模生產環境的 AI 系統,就會與現實發生碰撞。

例如,在實際 AI 生產工作負載中,SRAM 可能因為容量限制而受阻,難以向 HBM 那樣兼顧頻寬與密度。此外,黃仁勳也不斷強調,規模與變化才是關鍵瓶頸。即使在單一部署中,模型隨著上下文長度、路由邏輯或額外模態的增加,也可能超出記憶體容量。

一旦模型溢出 SRAM,效率優勢就會崩潰,此時系統不是停頓,就是需要外部記憶體,而專用設計的優勢就會消失。這也符合黃仁勳的回應,「如果我把一切都放在 SRAM 上,當然不需要 HBM 記憶體。但問題在於我能放入這些 SRAM 的模型大小,比起實際需求小約 100 倍。」

隨著 AI 的工作負載一直改變,有時是混合專家模型(MOE)、多模態模型、擴散模型、自動迴歸模型或者是序列服務管理(Sequential Server Management,簡稱 SSM)模型。黃仁勳指出,每一種架構對硬體造成的壓力都不盡相同。有些是記憶體受限,有些則會推高互連頻寬需求;有些需要極低延遲,有些則可以容忍批次處理與延遲,這些壓力都會隨時間動態轉移,「有時壓力會轉移到 NVLink 上,有時候會落在 HBM 記憶體上,有時三者都同時承受壓力」。

黃仁勳認為,或許可以把某個特定工作負載推到極限,但如果那 10% 或甚至 5% 的工作負載沒被使用,那資料中心部分資源本來可以被用來做別的事情。至於開放權重,並不能消除對大容量記憶體池、高速互連或靈活執行引擎的需求,它只是改變誰擁有模型而已。

從黃仁勳的說法來看,即便客戶抱怨 HBM 成本和 GPU 的價格,但他似乎認為這兩者之間不存在矛盾,如果 AI 模型趨於穩定或分化成可預測的層級才可能受影響,但他認為,NVIDIA 那個時刻尚未到來。

(首圖來源:shutterstock)