蘋果 M5 系列採台積電 N3P 製程,導入 SoIC 封裝提升效能 |

| 作者 蘇 子芸|發布日期 2026 年 03 月 04 日 10:11 | 分類 Apple , IC 設計 , 半導體 |

Category Archives: 半導體

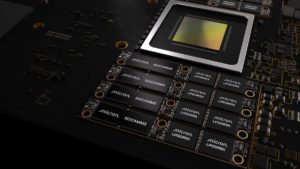

美光攜手輝達推 SOCAMM2 記憶體標準,AI 伺服器效能飆升六倍、功耗降低 66% |

| 作者 TechNews 編輯台|發布日期 2026 年 03 月 04 日 10:10 | 分類 AI 人工智慧 , 伺服器 , 記憶體 |

隨著人工智慧(AI)模型的創新速度遠超基礎設施的演進,記憶體架構已成為加速 AI 部署的關鍵槓桿。美光(Micron)與輝達(NVIDIA)合作開發的 SOCAMM(System-On-Chip Attached Memory Module)正從過往的專有技術轉型為 JEDEC 行業標準 SOCAMM2,成為解決「記憶體牆」挑戰的核心方案。 繼續閱讀..

MacBook Air 也喜迎升級,M5 晶片全面提升效能與 AI 處理 |

| 作者 邱 倢芯|發布日期 2026 年 03 月 03 日 22:58 | 分類 Apple , 晶片 , 筆記型電腦 |

蘋果這次的升級並沒有獨厚 14 吋與 16 吋 MacBook Pro,就連 13 吋與 15 吋 MacBook Air 也在這波迎來了 M5 晶片版本。新一代 MacBook Air 將效能、電力效率、AI 處理以及顯示與連線能力同步提升,為主流輕薄筆電市場帶來新一輪競爭基準。新機搭載高效能與低功耗設計、加速的媒體引擎、更快的 SSD、高效無線連接方案等一系列升級,目標在專業級工作、內容創作與行動辦公場景中提供更完整的體驗。

M5 Pro / M5 Max MacBook Pro 亮相,強勢提升 AI 與專業性能 |

| 作者 邱 倢芯|發布日期 2026 年 03 月 03 日 22:46 | 分類 Apple , 晶片 , 筆記型電腦 |

蘋果稍早除了發表最新一代高階晶片 M5 Pro 與 M5 Max 外,也同步發表搭載全新 M5 Pro 與 M5 Max 晶片的最新 14 吋與 16 吋 MacBook Pro 系列,重新設定專業筆電在 CPU、GPU、AI 運算與儲存效能上的表現基準。這兩款晶片與全新 MacBook Pro 機種融合了更高帶寬的統一記憶體、加速的儲存子系統與進階連結性,目標明確鎖定對處理複雜工作負載與裝置端AI運算有高需求的創作與商務族群。

擷發科秀軟硬整合實力!董座楊健盟:AI 邊緣落地最大挑戰在流程零碎化 |

| 作者 林 妤柔|發布日期 2026 年 03 月 03 日 18:01 | 分類 AI 人工智慧 , IC 設計 |

ASIC 設計服務與 AI 軟體解決方案領導廠商擷發科今(3 日)分享從 AI 模型開發到 ASIC 晶片設計的完整軟硬體整合量能。談到記憶體走勢,董事長楊健盟表示,目前市場研究預期缺貨情況可能延至 2028、甚至 2029、2030 年,DRAM 產業長期被看扁。 繼續閱讀..

記憶體漲價風暴來襲?宏碁遊戲:未見 PlayStation 主機調漲跡象 |

| 作者 邱 倢芯|發布日期 2026 年 03 月 03 日 17:29 | 分類 PlayStation , 記憶體 , 財經 |