可曾想過人為什麼會有「意識」?理解世界的「智能」又從何而來?這和處理器業界的年度盛事 Hot Chips 又有什麼千絲萬縷的關係?

被譽為世界科幻文學三巨頭之一的羅伯特·海萊恩(Robert Anson Heinlein),1961 年出版的《異鄉異客》(Stranger in a Strange Land),陳述在火星長大的孤兒,用非人類的眼光審視人類世界的故事。作者杜撰了一個字「Numenta」,來自拉丁文的「心靈」(Mentis)之意。

2005 年,知名計算機科學家兼神經生物學家 Jeff Hawkins、Donna Dubinsky 和 Dileep George 創立 Numenta,目標透過開發基於大腦新皮質的原理,創造機器智慧。之前 Jeff Hawkins 是 Palm 和 Handspring 創辦人,可謂掌上型運算領域先驅者,也創建紅杉神經科學研究所(Redwood Neuroscience Institute),身兼美國國家工程學院院士。

▲ Numenta 創辦人之一 Jeff Hawkins 是知名的計算機科學家與神經生物學家,更是 Palm、Handspring、紅杉神經科學研究所(Redwood Neuroscience Institute)和 Numenta 創辦者,曾主導 Palm 和 Treo 等早期掌上型運算平台研發,並撰寫《On Intelligence》(創智慧)和《A Thoudand Brains》(千腦)兩本人工智慧領域的名作。

據人類進化史,大腦皮質分為新皮層和古皮層,厚度約 2~4 公釐,位於腦半球頂層的新皮質,處理資料的手段與人類意識和知覺息息相關。

因此 Jeffrey 和夥伴一起寫了《On Intelligence》(中譯「創智慧」或「人工智慧的未來」),提出「階層式時序記憶」(HTM,Hierarchical Temporal Memory)演算法,為 Numenta 核心技術,藉模擬新皮層機制,以人類認知世界的方式學習世界,可儲存、學習、推論和長序列回憶。Numenta 成立宗旨,不外乎「逆向工程」新皮質,最終製造出以相同理念運作的人工智慧機器。

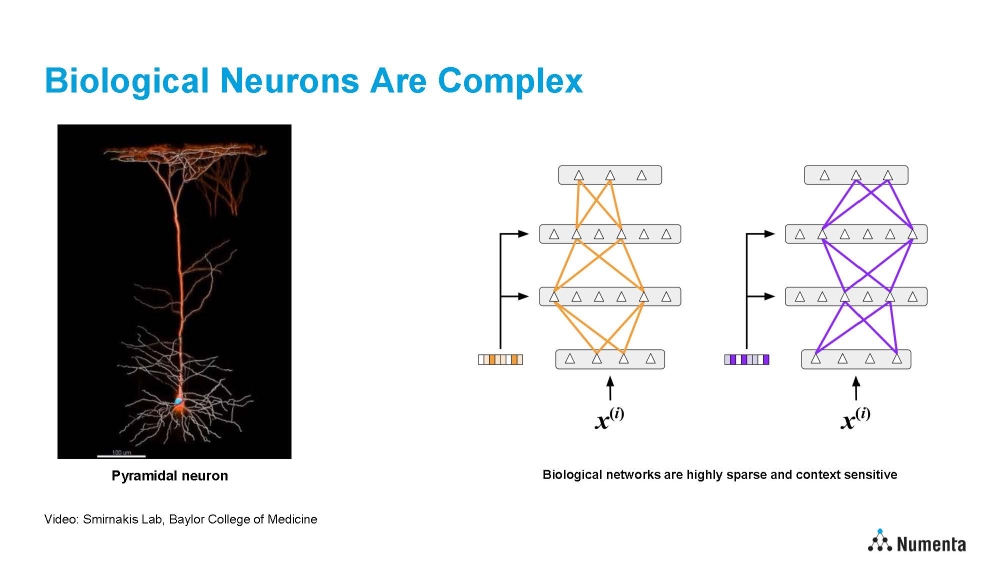

▲ 不同神經元模型比較:A. 人工神經網路。B. 生物神經元(新皮層錐體神經元)。C. HTM(階層式時序記憶)神經元。可清楚看到 Numenta 企圖變相複製更接近大腦的運作方式,再用於人工智慧。

Jeff Hawkins 2018 年出版《A Thoudand Brains》,後來被微軟創辦人比爾蓋茲(Bill Gates)列入 2021 年底聖誕閱讀清單,探討「千腦理論」(The Thousand Brains Theory)徹底改變我們對大腦和人工智慧前景的理解,介紹千腦理論如何影響機器智慧的未來,並試圖解釋大腦皮質每小部分都獨立學習對象模型,這些模型最後合併,形成整體認知。

換言之,人類智慧來自大腦無數個幾乎一模一樣的皮質柱(Cortical Column)共同作業,就好像大腦由「幾千個同時運行元件」組成。

更精確點,千腦理論可分成四部分:

- 「多重模型」:皮層每部分都獨立學習對象模型。這象徵有成千上萬皮層區域同時學習和建立相同對象的模型。

- 「多重表徵」:皮層每部分都獨立學習對象,代表大腦有多個同對象的表徵。

- 「投影框架」:大腦使用稱為投影框架的方法確定物體的空間位置,意謂我們不僅學習物體本身,還要學習物體與其他物體的相對位置。

- 「結合模型」:雖然皮層每部分都有獨立模型,但高層次整合或結合,形成完整的認知模型。

▲「千腦理論」是 Numenta 試圖解釋大腦皮層工作原理的神經科學理論,核心觀點在大腦皮層每小部分都獨立學習對象模型,這些模型最終會合併,形成整體認知。

既然 Numenta 開宗明義要「模仿人類大腦」,那像大腦與生俱來的「稀疏性(Sparsity)計算」(可參考筆者前篇中國墨芯文章),與避免神經網路學習新任務或新資料時,可能會完全或部分忘記以前學到的資訊或技能的「災難性遺忘」(Catastrophic Forgetting)造成連續學習(連續學習多任務,而不是從頭開始)於傳統神經網路的瓶頸,自然也是 Numenta 努力的重點。

▲ Jeff Hawkins 兩本著作構成 Numenta 公司的技術思路基礎,闡述「千腦理論」的後者還曾被被微軟創辦人比爾蓋茲列為 2021 年底聖誕閱讀清單。

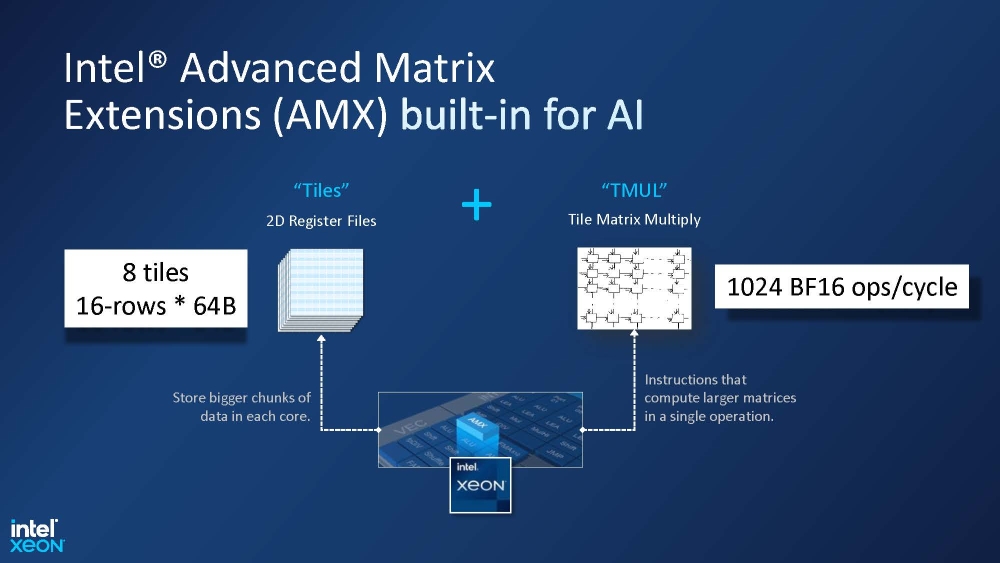

但你或許會疑惑:難道 Numenta 真要打造「與大腦同樣原理」的晶片?當然不是,且任何晶片都不做。Numenta 的訴求很簡單:普及的泛用伺服器處理器(通指英特爾 Xeon)就可靠 AVX-512 指令集和內建「AI 的下一大步」AMX(Advanced Matrix Extensions)矩陣加速器,跑出優異的推論效能,更不需缺貨缺很大、價格也貴森森的高階運算 GPU。這很可能讓人覺得 Numenta 的「格局」和這麼多年於 Hot Chips 猛衝「人工智慧」的眾多廠商,高下立判。

▲ 英特爾 AMX 發表超過三年,但到今年第一季第四代 Xeon-SP 處理器 Sapphire Rapids 才讓人一親芳澤。就讓我們看看 Numenta 如何發揮 AMX 對人工智慧的潛能。

歷經 20 年深入研究神經網路,不久前 9 月 11 日,Numenta 終於宣佈推出商業化人工智慧產品:Numenta 智慧運算平台(NuPIC,Numenta Platform for Intelligent Computing),為 HTM 演算法的實際商品,對應 C++、Python、Java 及 Clojure(Java 平台 Lisp)等程式語言版。

現在就讓我們好好瞧瞧今年 Hot Chips,Numenta 怎樣使用普遍部署的 CPU 解決人工智慧推理問題,如何活用 AVX-512 和 AMX,一睹足以讓英特爾自豪的成果。

▲ Numenta 的目標:受神經科學啟發,將更多大腦運作方式用於人工智慧。畢竟人腦功率約 20W,卻能超越功耗超出幾個量級的電腦。與為了密集計算(嘗試計算每種排列組合)而生的近代電腦,人腦是為大量稀疏計算(僅計算最相關和最有影響力組合)而設計。

▲ 神經元看起來很複雜,卻讓生物大腦在極度稀疏狀態運作。Numenta 將 HTM 演算法應用到新型 CPU,可將運算變得超稀疏,消除 90% 權重同時,提供相似的精確度。

▲ 使用 GPU 推論的技術限制:現今 GPU 專為超高密度矩陣乘法運算量身訂做,須持續填充資料才能維持高效處理,且缺乏彈性,混合 CPU 和 GPU 的「兩塊記憶體」基礎架構也造成額外麻煩和挑戰。

▲ Numenta 利用 AVX-512 指令集、AMX 和英特爾數學核心函式庫(MKL,Math Kernel Library),達成約 90% 稀疏率。

▲ 英特爾延宕多次的第四代 Xeon-SP 處理器 Sapphire Rapids 首次引進 AMX(Advanced Matrix Extensions),正如其名,旨在高效率矩陣運算,特色在 2D 結構的資料暫存器 Tile 和每個時脈週期可同時進行 1,024 個 BF16 格式資料計算的 TMUL(Tile Matrix Multiply)執行單元,同時支援 FP32、FP16 和 INT8。後繼第六代 Granite Rapids 將新增 AMX-COMPLEX 半精度浮點複數。這次 Numenta 將對世人展示真正威力。

▲ Numenta 同步使用 AVX-512 和 AMX,如 AMX 輸出 FP32 運算結果,用 AVX-512 轉換成 BF16,再回饋給 AMX 下一步計算,充分掩蓋 AMX 載入 Tile 的延遲,盡量保持運作單元滿載,達成最大計算量。

▲ Numenta 充分運用 AVX-512 和 AMX 加持下,56 核心的英特爾第四代 Xeon-SP 處理器,BERT(Bidirectional Encoder Representations from Transformers)模型推論效能達 19 倍、32 核心第四代 Xeon-SP Ice Lake 的 62 倍和 48 核心 AMD 第三代 EPYC Milan 的 123 倍。

▲ 結合 Numenta 的 HTM 演算法和英特爾 AMX,第四代 Xeon-SP 有 Nvidia A100 十倍的推論輸出率。

▲ 相同計算成本,Numenta 有明顯較高精確度。Numenta 目標在透過改變模型計算需求,調整實現準確性成本曲線。

▲ Numenta 不但證明英特爾 AMX 可明顯提升大型語言模型(LLM,Large Language Model)效率,更可怕的是,假若換裝成內建 64GB HBM2e 的 Xeon Max,還可再提高到「三倍」輸出率。

▲ 最後,Numenta 強調「整個 NuPIC 可以只用 CPU 跑」(NuPIC can run entirely on CPUs),這還真是 Numenta 和英特爾的共同勝利。

自從英特爾 2020 年 6 月發表 AMX 後,大概因一再延期與坊間極度陌生的刻板印象,加上拜 OpenAI 之賜的 Nvidia「皮衣教主」熱潮,少人關注這技術的實際潛力,但「20 年磨一劍」的 Numenta,卻讓世人在 Hot Chips 首次見識到真正威力──況且這兩家公司很明顯合作密切,否則近年「核戰」一直處於上風的 AMD 就不會當沙包猛打了──即使拖出沒有 AVX-512 的 AMD 第三代 EPYC Milan 有點勝之不武。

▲ 看來 Xeon Max 的 64GB HBM2e 的確有不錯效果,尤其對很吃頻寬的大型語言模型(LLM,Large Language Model)特別有效。

人工智慧使用者用英特爾 Xeon 處理器執行近似人類大腦推論的 Numenta,最大貢獻在「連一般伺服器也可跑很快」,不必癡癡等待缺貨的 Nvidia、尚未完備的 AMD MI300 與剛起步的英特爾 Gaudi 2 加速器。但話說回來,AMD 會不會全面性相容 AVX-512 後,也將實裝 AMX 納入之後產品計畫,頗值得觀察。

(首圖來源:Numenta)

延伸閱讀:

- 在人工智慧晶片戰場追逐 GPU 背影的英特爾

- Hot Chips 之後,熱潮逐漸消退的人工智慧處理器

- Linus Torvalds 對 AVX-512 的批評是否公道

- 如果 AMD 也支援 AVX-512 指令集會發生什麼事?

- 英特爾與 AMD 的 x86 伺服器戰爭編年史

- 英特爾能否重演資料中心戰場發動反擊的「核戰」副本?

- 英特爾該如何「補回」自廢武功的 AVX-512

- 英特爾繼續開了徹底改革 x86 指令集的第二槍,然後呢?

- 一覽處理器廠商的「人工智慧推論加速單元」:x86 篇

- Hot chips 2023》對手近逼,英特爾在資料中心戰場發動反擊的「核戰」

- Hot Chips 2023》來自中國的墨芯英騰 AI 推論加速器